Architektura ITPolecane tematy

Czym jest Open Compute Project – koncepcja taniej mocy obliczeniowej

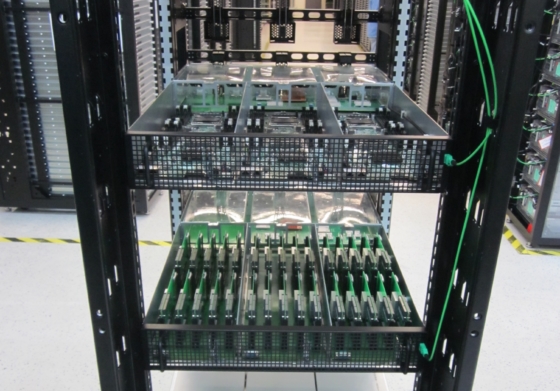

Celem działania organizacji Open Compute Project – w której działają m.in. takie firmy, jak Google, Facebook, Intel, IBM, Microsoft, Hewlett Packard Enterprise czy Cisco – jest osiągnięcie wydajnego, pojemnego a jednocześnie bardzo zaawansowanego centrum danych. OCP chce osiągnąć to poprzez synergię najlepszych osiągnięć technologicznych liderów tego świata w poszczególnych obszarach takich, jak: moc obliczeniowa, pamięci masowe i sieci.

Genezą powstania tej organizacji – jak to zwykle bywa – była potrzeba zbudowania, a w zasadzie zreorganizowania błyskawicznie rozwijającego się centrum danych firmy Facebook. W kwietniu 2011 Johnathan Heliger, ówczesny Vice President, Infrastructure & Technical Operations w Facebook ogłosił ideę otwartej rozmowy o pomysłach na centrum danych. Dzisiaj koncepcję tę wspierają naprawdę wielkie marki takie, jak wspomniane już Intel, Google, Microsoft i Cisco, ale także Apple, Rackspace, Ericsson czy nawet Bank of America. O szczegółach, historii tej inicjatywy i najważniejszych osobach pracujących w tym projekcie nie będę wspominał, bo najwięcej można dowiedzieć się o tym z portalu Wikipedia lub na stronie projektu – opencompute.org.

Wpływ OCP na obecne rozwiązania technologiczne

Powstaje jednak pytanie jak OCP wpłynie na udział w rynku klasycznych rozwiązań, znanych nam dzisiaj na rynku? Specyfikacja, czy architektura jaką opracowuje OCP bardzo szybko adoptują poszczególni producenci. Szczególnie Ci zaangażowani w tę ideę. Przykładowo AMD wprowadził już na początku 2013 platformę Open 3.0 Roadrunner. Na początku 2016 roku zaś – jeden z ważnych kontybutorów – Microsoft wprowadza wersję 2.1 do specyfikacji klatki serwerowej oraz serwera Blade. Widać zatem wielkie zaangażowanie producentów i parterów. Także na polskim rynku nie brakuje zainteresowania dużych instytucji tym rozwiązaniem.

Warto zauważyć że idea energooszczędnych i wydajnych rozwiązań centrum danych doskonale uzupełnia się z trendem rozwoju aplikacji trzeciej generacji, kontenerami i nowoczesnym procesem DevOps. Skoro już na poziomie kodu zakłada się, że będzie on uruchomiony na zunifikowanym kontenerze a skalowalność aplikacji zostanie osiągnięta przez jego multiplikację, to czemu nie zastosować tej idei w warstwie sprzętu? Praktycznie cała logika zarządzania cyklem życia aplikacji definiowana jest przecież przez oprogramowanie.

Warto zauważyć że idea energooszczędnych i wydajnych rozwiązań centrum danych doskonale uzupełnia się z trendem rozwoju aplikacji trzeciej generacji, kontenerami i nowoczesnym procesem DevOps. Skoro już na poziomie kodu zakłada się, że będzie on uruchomiony na zunifikowanym kontenerze a skalowalność aplikacji zostanie osiągnięta przez jego multiplikację, to czemu nie zastosować tej idei w warstwie sprzętu? Praktycznie cała logika zarządzania cyklem życia aplikacji definiowana jest przecież przez oprogramowanie. Można to zobaczyć choćby w rozwiązaniach VMware Software Defined Datacenter czy OpenStack.

Do czego zatem potrzebny byłby zarządzany silosowo – w zależności od producenta – komponent serwerowy. Znacznie lepszym pomysłem jest zbudowanie solidnej, jednolitej platformy w której można pomieścić jak najwięcej usług przy jak najmniejszym zużyciu energii. Tak właśnie zrobiły m.in. takie firmy, jak Facebook czy Google. Przy skali IT tych organizacji trudno sobie wyobrazić inne podejście. Nasuwa się myśl, że to co dzisiaj definiuje OCP to nic innego jak profesjonalne podejście do stosowanych niegdyś przez Google niezliczonych ilości komputerów PC jako serwerów.

Rozwiązania biznesowe zakładają rozproszenie i zunifikowanie

Ponadto gdy spojrzymy na najnowsze trendy w informatyce, które nieuchronnie zmierzają w stronę tzw. Business IT i analityki biznesowej zobaczymy, że rozwiązania dla biznesu natywnie zakładają platformy rozproszone i zunifikowane. Najlepszym przykładem mogą być klastry Hadoop, służące do wielkich obliczeń Big Data, gdzie sama architektura rozwiązania zakłada pełną redundancję warstwy serwerowej. Co za tym idzie nawet wirtualizacja przestaje być potrzebna, a przynajmniej nie przynosi korzyści takich, jakie zapewniała w projektach konsolidacyjnych. Nie dalej jak rok temu, VMware rozważał użycie komponentów OCP w platformach EVO:RACK. W tamtym czasie były one wprawdzie jedynie jeszcze zapowiedziami na rynku, ale już wymagały dalekiej optymalizacji w celu zapewnienia konkurencyjności.

Do czego zatem potrzebny byłby zarządzany silosowo – w zależności od producenta – komponent serwerowy. Znacznie lepszym pomysłem jest zbudowanie solidnej, jednolitej platformy w której można pomieścić jak najwięcej usług przy jak najmniejszym zużyciu energii. Tak właśnie zrobiły m.in. takie firmy, jak Facebook czy Google. Przy skali IT tych organizacji trudno sobie wyobrazić inne podejście. Nasuwa się myśl, że to co dzisiaj definiuje OCP to nic innego jak profesjonalne podejście do stosowanych niegdyś przez Google niezliczonych ilości komputerów PC jako serwerów.

Jedno jest pewne – podobnie jak w przypadku automatyzacji procesu rozwoju aplikacji – nie można przejść obok tego zagadnienia obojętnie. W tym miejscu przytoczę historię, która przydarzyła mi się z jednym z klientów. Otóż zaproponowałem utworzenie mechanizmu automatyzacji IaaS, szczególnie, że potrzebne do tego licencje były już w części przez niego zakupione. Wtedy jednak okazało się, że jakakolwiek automatyzacja nie jest w zakresie obecnych zainteresowań organizacji. Jakże jednak zmieniła się sytuacja, kiedy programiści wrócili do działu utrzymania z prośbą o wygenerowanie środowiska OpenStack stwierdzając, że resztą zajmą się już sami. Skutki? Można się spodziewać jak zareaguje dział utrzymania na taką deklarację. W moim przypadku brzmiała ona „musisz nas szybko nauczyć OpenStack’a”!

Podobnych schematów można się spodziewać w zakresie technologii centrów danych. Jeśli zignorujemy dzisiaj trend jakim jest Open Compute Project to może okazać się to zgubne w przyszłości. W końcu wiedza „tajemna” związana z zarządzaniem konkretnym rozwiązaniem serwerowym czy pamięci masowych w końcu przestanie mieć tak wielkie znaczenie, jakie ma dziś. W końcu nikt nie potrzebuje teraz specjalisty elektryka, aby podłączyć mikser w gospodarstwie domowym. Warto zatem stawiać na nowoczesność i już dziś rozważać takie platformy jak OCP.