Sztuczna inteligencjaRynekPolecane tematy

Nowy procesor Microsoftu przyspieszy działanie AI w chmurze Azure

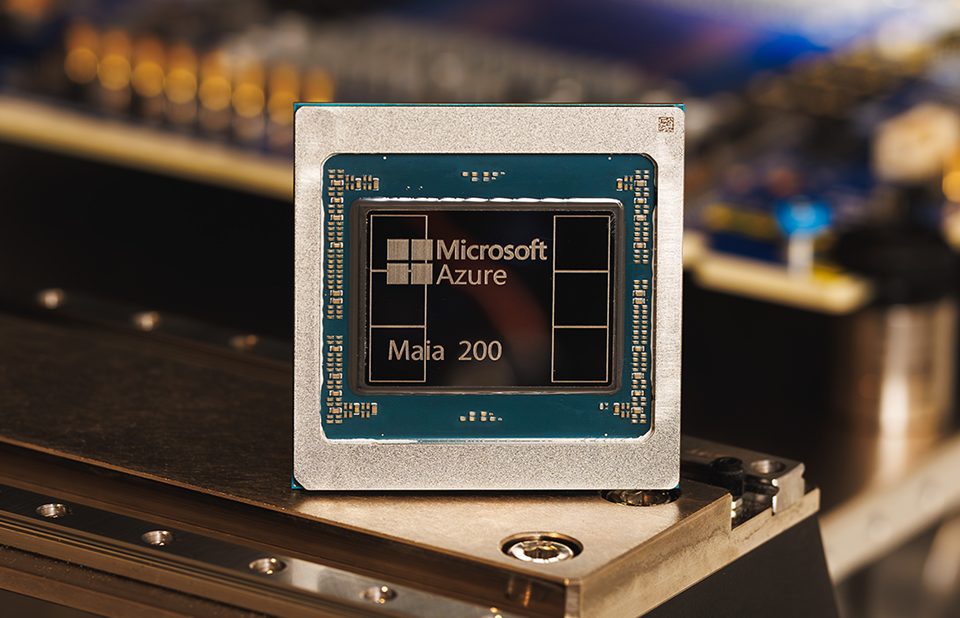

Microsoft wprowadza do centrów danych Azure nową generację własnych akceleratorów AI. Maia 200 to układ zaprojektowany specjalnie pod inferencję dużych modeli językowych. Ma on zapewnić lepszy stosunek wydajności do ceny niż rozwiązania konkurencji i wzmocnić niezależność infrastrukturalną platformy Azure.

Autorski akcelerator inferencyjny trafia właśnie do pierwszych regionów centrów danych Azure w USA. Maia 200 ma być fundamentem skalowalnych i bardziej opłacalnych wdrożeń modeli generatywnych, w tym Copilota i usług Microsoft Foundry.

Nowy układ wyprodukowano w procesie technologicznym 3 nm TSMC i zawiera ponad 100 mld tranzystorów. Układ jest zoptymalizowany pod obliczenia o niskiej precyzji – kluczowe dla inferencji nowoczesnych modeli AI. Oferuje ponad 10 petaFLOPS w trybie FP4 oraz około 5 petaFLOPS w FP8, co pozwala pojedynczemu węzłowi obsługiwać największe obecnie modele językowe z dużym zapasem mocy.

Istotnym wyróżnikiem jest także podsystem pamięci: 216 GB HBM3e o przepustowości 7 TB/s oraz 272 MB wbudowanej pamięci SRAM. Taka konfiguracja pozwala przechowywać większą część wag i danych lokalnie, ograniczając liczbę akceleratorów potrzebnych do uruchomienia modelu i poprawiając efektywność energetyczną.

Według przedstawicieli koncernu, Maia 200 zapewnia trzykrotnie wyższą wydajność FP4 niż Amazon Trainium trzeciej generacji oraz lepszą wydajność FP8 niż TPU siódmej generacji Google. Jednocześnie firma deklaruje o 30% lepszy stosunek wydajności do ceny w porównaniu z dotychczas wykorzystywanymi systemami inferencyjnymi w Azure.

Ujednolicona sieć i skalowanie bez zamkniętych technologii

Na poziomie systemowym Maia 200 wykorzystuje dwupoziomową architekturę skalowania opartą na Ethernet, zamiast zastrzeżonych interkonektów. Każdy akcelerator oferuje 1,4 TB/s przepustowości sieciowej (28 × 400 GbE), a klastry mogą skalować się do 6144 akceleratorów przy przewidywalnej wydajności operacji zbiorczych.

Cztery akceleratory w jednej tacy są połączone bezpośrednimi łączami o wysokiej przepustowości, a te same protokoły komunikacyjne wykorzystywane są na poziomie węzłów, szaf i klastrów. Uproszczona, jednolita struktura sieciowa ma ograniczać opóźnienia, redukować koszty i poprawiać wykorzystanie zasobów w skali całej chmury.

Pierwsze zastosowania i dalsze plany

Nowy układ w pierwszej kolejności zasili Microsoft Superintelligence, gdzie będzie wykorzystywany m.in. do generowania syntetycznych danych i ulepszania modeli nowej generacji. Trafi także do produkcyjnych obciążeń AI, takich jak Microsoft 365 Copilot, a w kolejnych etapach ma być udostępniany klientom Azure.

Jak poinformowano, Maia 200 to nie jednorazowy projekt, lecz początek wielogeneracyjnego programu własnych akceleratorów AI.