Sztuczna inteligencjaPolecane tematy

MIT Lab: nadużywanie modeli LLM negatywnie wpływa na funkcje poznawcze

MIT Lab zakończył pierwsze badanie polegające na skanowaniu mózgu użytkowników korzystających z dużych modeli językowych za pośrednictwem produktów takich, jak ChatGPT. W badaniu oceniano akumulację długu poznawczego podczas korzystania z asystenta AI w pisaniu eseju.

Dzięki powszechnemu dostępowi do produktów opartych o modele LLM, takich jak ChatGPT, ludzie i firmy korzystają z nich na co dzień. Badanie MIT Lab koncentrowało się na określeniu kosztu poznawczego związanego z korzystaniem z nich.

Wsparcie narzędzi AI a liczba połączeń nerwowych

Uczestników podzielono na trzy grupy: grupę LLM, grupę Search Engine i grupę Brain-only, gdzie każdy uczestnik korzystał z wyznaczonego narzędzia (lub nie korzystał z żadnego) do napisania eseju.

Przeprowadzono 3 sesje z tym samym zadaniem grupowym dla każdego uczestnika. Podczas czwartej poproszono uczestników grupy LLM o niekorzystanie z narzędzi (nazwano je LLM-to-Brain), a uczestników grupy Brain-only poproszono o korzystanie z LLM (Brain-to-LLM). Zrekrutowano 54 uczestników na sesje 1, 2 i 3, a 18 uczestników ukończyło sesję 4.

Wykorzystano elektroencefalografię (badanie EEG) do rejestracji aktywności mózgu uczestników, aby ocenić ich zaangażowanie i obciążenie poznawcze, a także uzyskać głębsze zrozumienie aktywacji neuronalnych podczas pisania eseju.

Następnie przeprowadzono analizę NLP i wywiady z każdym uczestnikiem, po każdej sesji. Punktacji dokonali nauczyciele i sędzia AI (specjalnie zbudowany agent AI).

Wnioski z badania wykorzystania modeli LLM

Odkryto stałą jednorodność w rozpoznawaniu jednostek nazwanych (NER), n-gramach i ontologii tematów w każdej grupie. Analiza EEG dostarczyła solidnych dowodów na to, że grupy LLM, Search Engine i Brain-only miały istotnie różne wzorce połączeń neuronowych, odzwierciedlające rozbieżne strategie poznawcze.

„Połączenia mózgowe systematycznie malały wraz z rosnącą ilością wsparcia zewnętrznego: grupa Brain-only wykazywała najsilniejsze i najszersze sieci neuronowe. Grupa Search Engine wykazywała średnie zaangażowanie, a pomoc LLM wywołała najsłabsze ogólne sprzężenie” – można przeczytać w opisie eksperymentu.

„W sesji 4 uczestnicy programu LLM-only wykazali słabszą łączność neuronową i słabsze zaangażowanie sieci alfa i beta. Uczestnicy Brain-only wykazali się lepszym przywoływaniem wspomnień i ponownym zaangażowaniem rozległych węzłów potyliczno-ciemieniowych i przedczołowych, prawdopodobnie wspierając przetwarzanie wzrokowe, podobnie jak często obserwowano w grupie Search Engine” – wyjaśniają naukowcy MIT Lab.

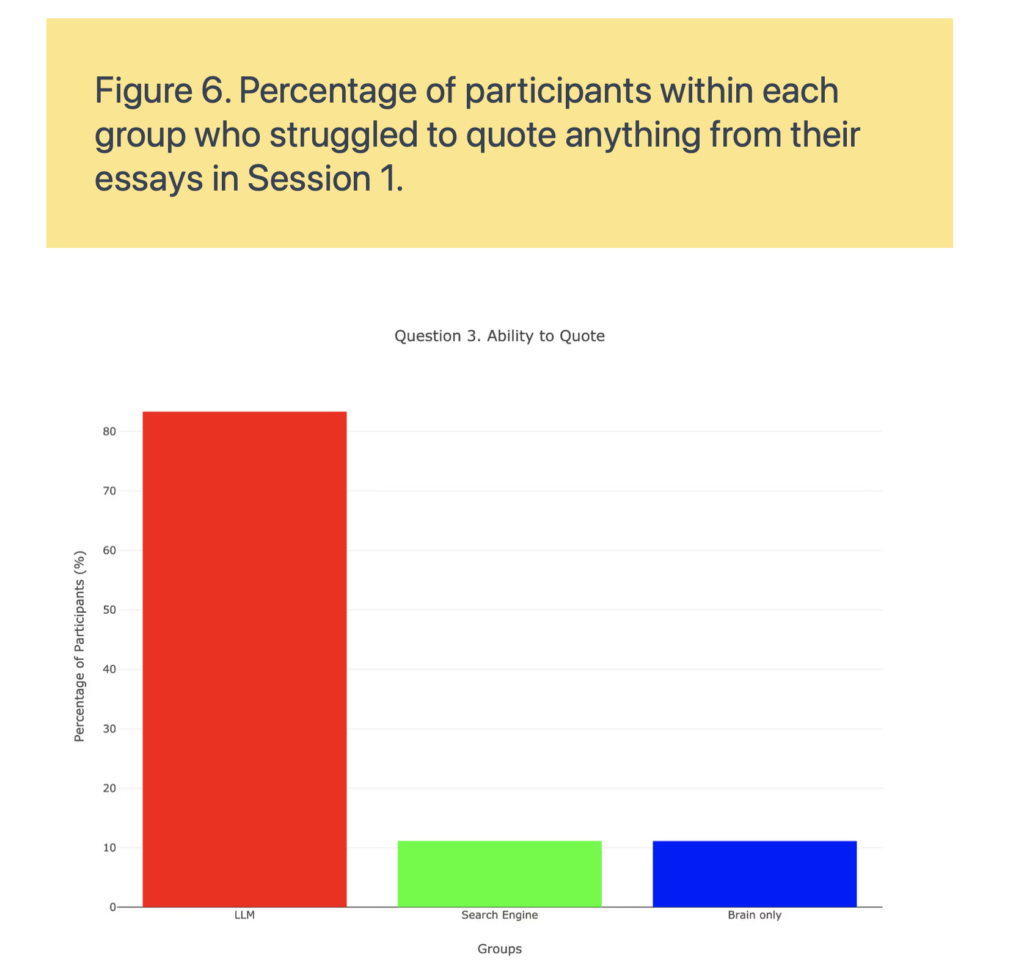

„Grupa LLM miała również gorsze wyniki w cytowaniu esejów napisanych zaledwie kilka minut wcześniej” – dodają.

Konieczność zbadania wpływu modeli LLM na umiejętności uczenia

„Ponieważ edukacyjny wpływ wykorzystania LLM dopiero zaczyna się ustabilizować w populacji ogólnej, w niniejszym badaniu wskazujemy na pilną kwestię zbadania możliwego spadku umiejętności uczenia się w oparciu o wstępne wyniki naszego badania” – apelują naukowcy.

Wykorzystanie LLM miało wymierny wpływ na uczestników eksperymentu MIT Lab, a chociaż korzyści były początkowo widoczne to – jak wykazano w trakcie 4 sesji, która trwała ponad 4 miesiące – uczestnicy grupy LLM uzyskali gorsze wyniki niż ich odpowiednicy z grupy Brain-only na wszystkich poziomach: neuronalnym, językowym i punktowym.

Najważniejsze wnioski z badania wpływu modeli LLM na uczenie

Dłuższe korzystanie ze sztucznej inteligencji zamiast pobudzać funkcje mózgu może je osłabiać. Ponad 4 miesiące danych poznawczych sugerują, że możemy błędnie mierzyć produktywność wykorzystując modele LLM.

Aż 83,3% użytkowników tego narzędzia nie było w stanie przypomnieć sobie ani jednego zdania, które napisali zaledwie kilka minut wcześniej. Natomiast osoby piszące bez sztucznej inteligencji nie miały problemów z zapamiętywaniem.

Połączenia mózgowe w przypadku grupy LLM spadła gwałtownie z 79 do 42 punktów. Oznacza to 47 proc. spadek zaangażowania neuronów. Osoby korzystające z ChatGTP miały najniższe wyniki poznawcze wśród wszystkich grup użytkowników.

Nawet po zaprzestaniu korzystania z ChatGPT w kolejnych sesjach, u tych użytkowników nadal utrzymywał się niski poziom zaangażowania. Ich wyniki były gorsze od wyników osób, które nigdy nie korzystały ze sztucznej inteligencji. Sugeruje to coś więcej niż uzależnienie – to osłabienie poznawcze.

Oprócz skanów nauczyciele zwrócili uwagę na sam tekst. Eseje były technicznie solidne, ale często określano je mianem „robotycznych”, „bezdusznych” i „pozbawionych głębi”.

Paradoksalnie, dzięki ChatGPT możesz wykonywać zadania o 60% szybciej… Jednak zmniejsza wysiłek umysłowy potrzebny do nauki o 32%.

Najlepsze wyniki osiągnęła ta grupa, która zaczynała pisanie esejów bez sztucznej inteligencji i dodała możliwość korzystania z modeli LLM później. Grupa Brain-to-LLM zachowała najlepszą pamięć, aktywność mózgu i ogólne wyniki.

„Korzystanie z ChatGPT może dać poczucie siły, ale może też po cichu odciążyć Cię od myślenia. Zyskujesz prędkość, ale tracisz zaangażowanie. Dostajesz odpowiedzi, ale przestajesz uczyć się myśleć” – to wnioski z badania, które należy dalej sprawdzić.

Wnioskiem nie jest unikanie sztucznej inteligencji, ale jej świadome wykorzystywanie. Używaj jej, aby wspomagać, a nie zastępować umysł. Buduj siłę poznawczą, a nie zależność.

MIT Lab: konieczne jest dalsze badanie wpływu modeli LLM

„Mamy nadzieję, że niniejsze badanie posłuży jako wstępny przewodnik, który zachęci do lepszego zrozumienia poznawczego i praktycznego wpływu sztucznej inteligencji na środowiska edukacyjne” – mówią naukowcy MIT Lab.

Wskazują też na kilka ograniczeń i ważnych kierunków przyszłych prac, które będą musiały zostać uwzględnione w kolejnych lub podobnych badaniach:

- W badaniu MIT Lab wzięli udział uczestnicy zrekrutowani z określonego obszaru geograficznego, z kilku dużych instytucji akademickich, zlokalizowanych bardzo blisko siebie. W przyszłych pracach ważne będzie włączenie większej liczby uczestników o zróżnicowanym doświadczeniu, takich jak specjaliści z różnych dziedzin i grup wiekowych, a także zapewnienie większej równowagi płci.

- Badanie zostało przeprowadzone z wykorzystaniem ChatGPT i nie można bezpośrednio uogólnić uzyskanych wyników na inne modele LLM. Dlatego w przyszłych pracach ważne będzie uwzględnienie kilku modeli LLM i/lub zaoferowanie użytkownikom możliwości wyboru preferowanego modelu.

- Przyszłe prace mogą również obejmować wykorzystanie modeli LLM z innymi metodami poza tekstem, takimi jak audio.

- Nie podzielono zadania pisania eseju na podzadania, takie jak generowanie pomysłów, pisanie itd., co często ma miejsce w poprzednich pracach. Takie etykietowanie może być przydatne do zrozumienia, co dzieje się na każdym etapie pisania eseju i do przeprowadzenia bardziej dogłębnej analizy.

- W obecnej analizie EEG skupiono się na raportowaniu wzorców łączności bez badania zmian mocy widmowej, co mogłoby zapewnić dodatkowe spostrzeżenia dotyczące wydajności neuronowej. Rozdzielczość przestrzenna EEG ogranicza precyzyjną lokalizację głębokich obszarów korowych lub podkorowych (np. hipokampu), dlatego wykorzystanie fMRI jest kolejnym krokiem w naszej przyszłej pracy.

- Ustalenia zależą od kontekstu i koncentrują się na pisaniu eseju w środowisku edukacyjnym, a ich wyniki mogą nie mieć zastosowania do innych zadań.

- Przyszłe badania powinny również uwzględniać długofalowy wpływ korzystania z narzędzi na retencję pamięci, kreatywność i płynność pisania.