WydarzeniaInfrastrukturacentra danych / data centerPREZENTACJA PARTNERA

Centrum danych chłodzone cieczą: szanse i wyzwania

Advertorial

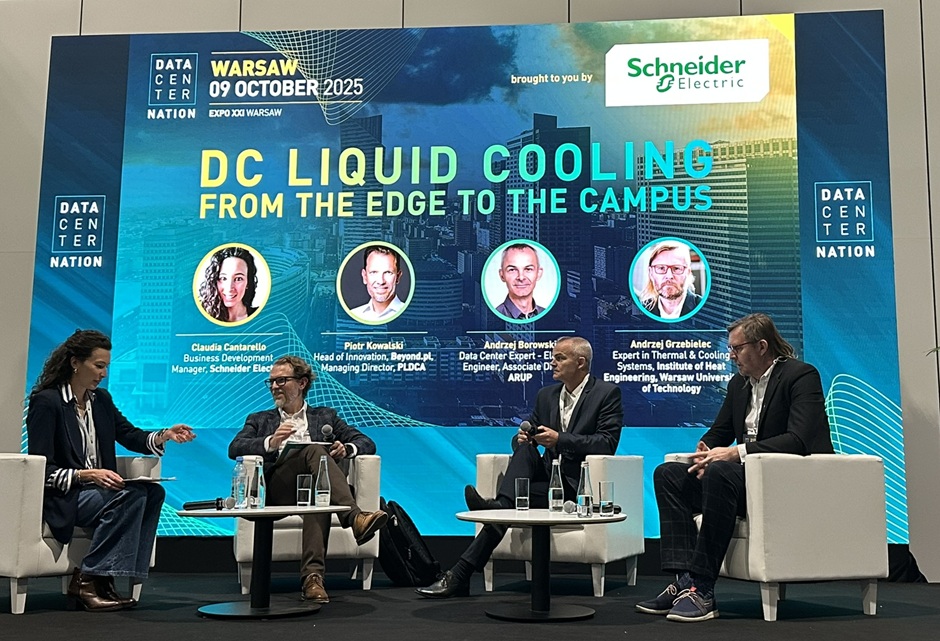

Sztuczna inteligencja winduje wymagania względem infrastruktury IT i nakłada nowe wyzwania na centra danych, zwłaszcza w obszarze zasilania i odprowadzania ciepła. Zorganizowany podczas konferencji Data Center Nation panel Schneider Electric był okazją do dyskusji na temat technologii Liquid Cooling. Technologii, która nie ma dziś realnych alternatyw.

Jesień obfituje w unikalne wydarzenia związane z polską branżą ICT. Tradycyjnie już, jednym z ważniejszych eventów dla branży data center była konferencja Data Center Nation. W ramach kontynuowanego od trzech lat formatu, wydarzenie to skupiło blisko 20 debat i prelekcji, zgromadziło dziesiątki dostawców oraz setki osób związanych zawodowo z infrastrukturą centrów danych.

Dyskusje zorganizowane podczas warszawskiej edycji wydarzenia poświęcone były m.in. trendom i wyzwaniom kształtującym rynek data center, zmieniającym się potrzebom klientów oraz użytkowników centrów danych, wymaganiom inwestycyjnym, a także kwestiom środowiskowym i geopolitycznym. Nie zabrakło też debat poświęconych konkretnym koncepcjom, rozwiązaniom i technologiom wspierającym transformację centrów danych.

Kluczowe znaczenie dla transformacji infrastruktury data center ma dziś m.in. dynamiczny rozwój technologii sztucznej inteligencji. AI winduje wymagania względem mocy obliczeniowej, co zmienia szereg obowiązujących dotąd paradygmatów dotyczących projektowania oraz obsługi infrastruktury IT.

Jak AI wpływa na potrzeby względem centrów danych?

Systemy wyspecjalizowane pod kątem obsługi obciążeń wykorzystujących sztuczną inteligencję cechuje istotnie wyższa wydajność, ale też – potrzeba lokalizowania węzłów obliczeniowych oraz pamięci masowych w jak najmniejszej fizycznej odległości, aby do minimum ograniczyć ewentualne opóźnienia w transmisji danych. Efektem jest radykalny wzrost gęstości mocy w jednostce powierzchni. Tym samym rozwiązania biznesowe wykorzystujące AI upodabniają się pod względem charakterystyki wymagań do wysokiej wydajności systemów klasy HPC (High-Performance Computing). Jednocześnie, wspomniana chęć ograniczenia opóźnień w przesyłaniu danych przekłada się na rosnące zainteresowanie koncepcją przetwarzania brzegowego, a więc lokowania środowisk AI jak najbliżej źródeł danych, czyli niekoniecznie w centralnych, dużych centrach danych.

Z kolei z perspektywy operatorów data center, rosnąca popularność obciążeń AI oznacza konieczność zapewnienia odpowiednio wysokiej mocy zasilania, odprowadzenia znacząco wyższych ilości ciepła, a nierzadko gruntownej modernizacji infrastruktury centrum danych. Motorem takich zmian staje się konieczność zapewnienia wysokiej mocy zasilania szaf serwerowych dedykowanych do obsługi AI oraz odprowadzenia ciepła generowanego na dużo większą skalę niż w przypadku tradycyjnych systemów.

Taki skokowy wzrost ilości energii cieplnej emitowanej przez infrastrukturę IT przekłada się na konieczność zastosowania nowoczesnych technologii chłodzenia – rozwiązania oparte na wymianie powietrza okazują się niewystarczające. Tej właśnie kwestii poświęcony był panel dyskusyjny zorganizowany przez Schneider Electric.

Rewolucja w świecie IT motorem zmian w centrach danych

Celem panelu było przybliżenie istotnych informacji o możliwościach wykorzystania Liquid Cooling (chłodzenia cieczą) w kontekście zmieniających się potrzeb względem IT, a także szans i wyzwań związanych z upowszechnieniem tej technologii – również na rynku polskim. „Potencjał sztucznej inteligencji jest ogromny. AI wymaga jednak ogromnych ilości energii, którą najpierw trzeba dostarczyć do centrum danych, a następnie – w formie ciepła – odprowadzić” – mówiła Claudia Cantarello, Business Development Manager w Schneider Electric.

Dostępne dziś serwery AI generują ponad dziesięciokrotnie większe ilości ciepła niż konwencjonalne serwery, a oczekiwania względem stopnia upakowania tego typu sprzętu w szafach serwerowych rośnie. „Dzisiejsze, wyspecjalizowane pod kątem obsługi AI, szafy serwerowe typu rack dysponują mocą rzędu 140 kW, ale według prognoz niebawem dostępne będą szafy o mocy na poziomie 1 MW. To odpowiednik 200 piekarników kuchennych, umieszczonych jednak w zdecydowanie mniejszej przestrzeni” – dodała Claudia Cantarello. W takich realiach tradycyjne systemy chłodzenia powietrzem, projektowane dla radykalnie niższych mocy cieplnych, okazują się wysoce niewystarczające. „Rosnąca gęstość strumieni ciepła systemów IT zmienia zasady gry na rynku centrów danych. Nie ma tu również miejsca na jakikolwiek błąd, bo sprzęt wykorzystywany na potrzeby AI jest wrażliwy na przegrzanie i bardzo drogi. Musimy zatem zapewnić nieprzerwane i odpowiednio wydajne chłodzenie” – podkreślał Piotr Kowalski, Head of Innovation w Beyond.pl, dyrektor zarządzający Polish Data Center Association.

Dlaczego Liquid Cooling (chłodzenie cieczą)?

Wraz z rosnącym wykorzystaniem sztucznej inteligencji, potrzebą szybszego przetwarzania ogromnych wolumenów danych i zwiększaniem gęstości tradycyjnych systemów IT, kluczowe staje się odprowadzenie coraz większej ilości ciepła. W kontekście aktualnej specyfiki centrów danych, duże znaczenie ma tu bowiem zapewnienie uniwersalności i elastyczności wykorzystania infrastruktury – obsługi zróżnicowanych obciążeń, tych tradycyjnych, ale też najbardziej wymagających pod kątem energetycznym i cieplnym. „Mając doświadczenia z działalności operacyjnej Beyond.pl mogę powiedzieć, że zbudowanie infrastruktury zapewniającej elastyczność, jeśli chodzi o obsługiwane systemy IT, jest dziś koniecznością. Centra danych trzeba projektować tak, aby zachowały jak największą uniwersalność. Rozwiązania chłodzenia cieczą są tu bardzo pomocne” – stwierdził Piotr Kowalski.

Rozsądną alternatywą dla chłodzenia powietrzem okazują się rozwiązania, w których medium wykorzystywanym do odprowadzania ciepła jest ciecz. Kluczowe znaczenie mają tu dużo wyższe współczynniki pochłaniania ciepła, a także – możliwość precyzyjnego odbierania ciepła z powierzchni kluczowych układów. „Ciecz jest w stanie zaabsorbować kilkukrotnie większą ilość ciepła niż ta sama ilość powietrza. W połączeniu z możliwością punktowego odprowadzania ciepła odpadowego oznacza to wyższą efektywność chłodzenia systemów wysokiej gęstości, a także niższe koszty” – powiedziała Claudia Cantarello.

Technologie chłodzenia cieczą mają potencjał, aby stać się fundamentem dla infrastruktury odprowadzania ciepła w nowoczesnych centrach danych. „W ciągu kilku najbliższych lat chłodzenie cieczą stanie się dominującą technologią – i to niezależnie od wielkości centrum danych. Będzie to pochodna rosnącej gęstości strumieni ciepła. Ciecz stwarza możliwości zupełnie innej skali niż technologie chłodzenia powietrzem” – przekonywał dr. inż. Andrzej Grzebielec, ekspert systemów grzewczych i chłodniczych, adiunkt w Instytucie Techniki Cieplnej Politechniki Warszawskiej. Według niego, już dziś zapewnienie odpowiedniej efektywności chłodzenia staje się problemem w wielu centrach danych.

Taki kierunek potwierdzają m.in. prognozy dotyczące rozwoju światowego rynku technologii chłodzenia cieczą. Według licznych analiz, do końca 2029 roku wycena globalnego rynku rozwiązań chłodzenia cieczą dla centrów danych przekroczy 10 mld USD. Dla porównania, wedle prognoz firmy Omida, pod koniec 2024 roku wartość tego rynku wynosiła ok. 1,9 mld USD.

„Jako Schneider Electric od dawna przygotowujemy się do takich wyzwań. Na początku 2025 roku kupiliśmy wyspecjalizowaną w chłodzeniu systemów HPC firmę Motivair. Dziś, na bazie wspólnych doświadczeń, dysponujemy najbardziej kompleksową ofertą rozwiązań chłodzenia cieczą na rynku” – podkreśliła Claudia Cantarello. „Oferujemy rozwiązania obejmujące cały proces odprowadzania ciepła – od układów po agregaty chłodnicze. Wspieramy klientów na wszystkich etapach – od projektu, aż po budowę. Mamy rozwiązania przeznaczone dla dowolnych centrów danych – od najbardziej wymagających fabryk AI po brzegowe data center” – zapewniła.

Liquid Cooling jedynym rozwiązaniem na przyszłość?

Za wykorzystaniem rozwiązań chłodzenia cieczą przemawiają również polskie uwarunkowania środowiskowe. „Polska charakteryzuje się najniższą średnią temperaturą w Europie Środkowej i Południowej. W naszym klimacie możemy z powodzeniem wykorzystywać technologie dry cooling bez konieczności dodatkowego ochładzania cieczy” – mówił Piotr Kowalski. Według niego, w polskim klimacie możliwe jest nawet efektywne chłodzenie infrastruktury AI bez zastosowania urządzeń mechanicznych. „Jeśli chodzi o efektywność chłodzenia, a także z perspektywy zrównoważonego rozwoju, Polska jest jednym z najlepszych miejsc do lokowania centrów danych” – dodał Piotr Kowalski. Zdaniem eksperta postęp w dziedzinie systemów odprowadzania ciepła sprawi, że chłodzenie cieczą stanie się standardem także dla mniejszych, brzegowych centrów danych.

Właściwe zaprojektowanie infrastruktury chłodzenia dla nowoczesnych obiektów data center nie jest jednak zadaniem łatwym. „Wyzwaniem staje się dziś takie zaprojektowanie infrastruktury data center, aby zapewnić elastyczność jej wykorzystania w perspektywie kolejnych lat. Proszę pamiętać, że obecnie projektujemy centra danych, które zobaczymy w działaniu za co najmniej trzy lata” – mówił Andrzej Borowski, dyrektor zarządzający i specjalista ds. projektowania centrów danych w firmie Arup.

Taki horyzont czasowy wymaga m.in. przewidywania zmian w zastosowaniu centrów danych i charakterystyce potencjalnych obciążeń. Jednocześnie, w długiej perspektywie kluczowe znaczenie dla możliwości obsłużenia różnych rodzajów obciążeń mają zastosowane rozwiązania zasilania i odprowadzania ciepła. Wybór odpowiednich rozwiązań w tym zakresie nabiera zatem strategicznego charakteru dla inwestycji w centra danych.

Ekspert zwrócił również uwagę na zależności pomiędzy charakterystyką infrastruktury odprowadzania ciepła, a efektywnością energetyczną centrów danych. „Zastosowanie rozwiązań chłodzenia opartych na cieczy pozwala zmniejszyć wskaźnik PUE w typowych centrach danych nawet poniżej 1,2” – podkreślił Andrzej Borowski. „W lepszym zagospodarowaniu przestrzeni centrum danych pomagają m.in. rozwiązania odprowadzania ciepła bezpośrednio z układów obliczeniowych. Dzięki temu, najbardziej energochłonne układy, jak GPU, mogą funkcjonować w ramach infrastruktury o wyższej temperaturze otoczenia” – dodała Claudia Cantarello.

Modernizować czy budować od podstaw?

Wybór modelu rozbudowy obiektów data center, które zapewniłyby uniwersalność i szerokie możliwości obsługi zróżnicowanych obciążeń w ujęciu długoterminowym to kolejna nieoczywista kwestia. „Modernizacja istniejącej infrastruktury może być tańsza i bardziej korzystna z perspektywy zrównoważonego rozwoju, ale dostosowanie starszego centrum danych do aktualnych realiów może wymagać zmiany całego podsystemu zasilania oraz odprowadzania ciepła, a tu ograniczeniem może okazać się struktura istniejącego budynku” – podkreślił Andrzej Borowski. Jego zdaniem realizacja tego typu projektów może wymagać m.in. rekonfiguracji infrastruktury elektrycznej i mechanicznej, co okazuje się dużym wyzwaniem. Na tym tle prostsze w realizacji mogą być inwestycje typu greenfield.

„Wyposażenie istniejącego, działającego centrum danych w system chłodzenia cieczą brzmi łatwo, ale w szczegółach zwykle jest inaczej. Przykładowo, szafy serwerowe chłodzone cieczą są dużo cięższe od tych, dostosowanych do chłodzenia powietrzem. Zwykle są także wyższe, bo te wszystkie rurki i wymienniki ciepła, także zajmują przestrzeń. Potrzebna może okazać się bardziej gruntowna przebudowa” – wskazał Piotr Kowalski. Jego zdaniem, istotna jest też kwestia dostosowania modernizowanego data center do nowych wymagań w zakresie zasilania – w dobie AI może okazać się, że kilka serwerów wykorzysta całość projektowej mocy istniejącego data center. „Wszystko to może okazać się trudne, ale nie jest niemożliwe. Beyond.pl jest tu najlepszym przykładem. Początkowo nasze data center było zaprojektowane pod kątem mocy rzędu 5MW. Udało nam się jednak, w ramach tego samego budynku, zwiększyć moc zasilania naszego data center aż do 42MW” – zapewnił Piotr Kowalski.

„Warto zatem eksperymentować i testować możliwości użycia systemów Liquid Cooling w obiektach pierwotnie zaplanowanych jako chłodzone powietrzem. Stosowne rozwiązania są dziś dostępne” – dodała Claudia Cantarello. Co ważne, możliwe jest także wykorzystanie rozwiązań pośrednich, opartych w części na technologii chłodzenia cieczą, a częściowo – powietrzem. Systemy liquid-to-air mogą okazać się szczególnie przydatne właśnie w ramach projektów modernizacji istniejących data center.

Początek drogi do powszechności

Zdaniem uczestników panelu, przejście na systemy chłodzenia cieczą jest niezbędnym krokiem na drodze do budowy centrów danych w pełni gotowych obsłużyć obciążenia AI na dużą skalę. „Myślę, że technologie chłodzenia cieczą będą się rozwijać. Aby jednak było to realne, niezbędne jest zacieśnienie współpracy pomiędzy sektorem data center, dostawcami technologii, instytucjami badawczymi, ale też organizacjami naukowymi i administracją publiczną” – skwitował Andrzej Grzebielec. Jego zdaniem, kluczowe znaczenie dla możliwości upowszechnienia technologii chłodzenia cieczą w centrach danych będzie miało wypracowanie dobrych praktyk wspierających realizację takich projektów w ramach lokalnych – polskich i europejskich – uwarunkowań. Co znaczące, własne doświadczenia z chłodzeniem wysoce wydajnych systemów IT mają także instytucje publiczne, w tym m.in. Cyfronet AGH czy Poznańskie Centrum Superkomputerowo-Sieciowe.

Ważne może okazać się zatem korzystanie ze sprawdzonych rozwiązań w zakresie architektury systemów chłodzenia cieczą, ale też – prace badawczo-rozwojowe. „Musimy pamiętać, że dalszy wzrost gęstości mocy może doprowadzić do sytuacji, w której dzisiejsze rozwiązania okażą się niewystarczające. Dlatego już teraz prowadzimy badania nad zastosowaniem innych cieczy, które będzie można wykorzystać w istniejących instalacjach, aby poprawić ich efektywność w zakresie transferu ciepła. W zwiększeniu wydajności odbioru ciepła przez ciecze pomocne mogą okazać się, przykładowo, nanocząstki” – dodał Andrzej Grzebielec.

Ciepło do wykorzystania

Wielodziedzinowej współpracy wymagać może też wykorzystanie potencjału technologii chłodzenia cieczą w celu zagospodarowania ciepła odpadowego z centrów danych z korzyścią dla środowiska, użytkowników i operatorów systemów ciepłowniczych, a także – operatorów data center. „Centra danych produkują ogromne ilości ciepła, które dziś najczęściej jest marnowane. Wdrożenie systemów chłodzenia cieczą pozwala zmienić ten stan rzeczy, wykorzystać ciepło odpadowe, poprawić efektywność energetyczną centrów danych i zmniejszyć ślad węglowy takich obiektów” – podkreślił Artur Borowski.

Potencjał tego rodzaju projektów jest naprawdę znaczący. Niewykorzystane ciepło może zostać użyte do ogrzewania różnego rodzaju obiektów – od mieszkań, przez obiekty infrastruktury publicznej, po fabryki i zakłady produkcji rolnej.

Inicjatywy w tym obszarze doskonale wpisują się w potrzeby zrównoważonego rozwoju. Czyniąc z centrum danych źródło odnawialnej energii, pomagają zwiększyć efektywność energetyczną takich obiektów ograniczając jednocześnie ich ślad węglowy. Doskonałym przykładem jest tutaj Beyond.pl, który od dwóch lat wspólnie z Veolia Energia Poznań, realizuje pionierski projekt zakładający wykorzystanie na dużą skalę ciepła generowanego przez infrastrukturę IT do zasilania miejskich sieci ciepłowniczych. Docelowo eksport ciepła z centrum danych Beyond.pl może pokryć nawet 20% potrzeb cieplnych Poznania.