Sztuczna inteligencjaBiznesRynek

HPE i NVIDIA opracowały portfolio rozwiązań pozwalających na szybsze wdrażanie GenAI

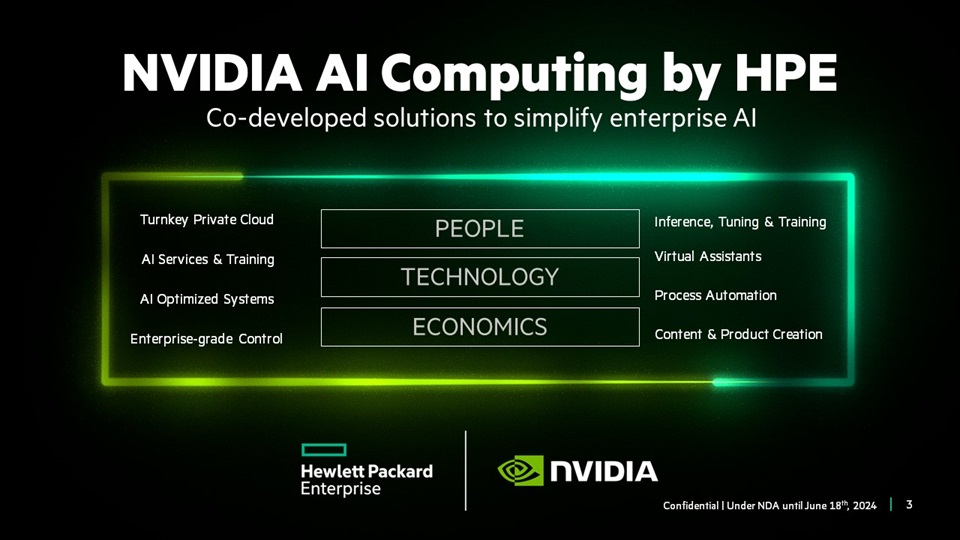

Mowa o kompleksowej ofercie NVIDIA AI Computing by HPE, która jest wynikiem poszerzonego partnerstwa obu firm. Jednym z jej kluczowych komponentów jest HPE Private Cloud AI. Rozwiązanie to zapewnia integrację narzędzi AI, sieciowych i software’owych firmy NVIDIA z pamięcią masową, rozwiązaniami obliczeniowymi oraz chmurowymi HPE GreenLake.

Jak zapewniają przedstawiciele obu firm, HPE Private Cloud AI to unikalne, oparte na chmurze rozwiązanie. Przyspiesza ono wprowadzanie innowacji i pozwala szybciej uzyskać zwrot z inwestycji, przy jednoczesnym zarządzaniu ryzykiem przedsiębiorstwa wynikającym ze stosowania AI. Obejmuje następujące elementy:

- Obsługę wnioskowania, dostrajania i obciążeń RAG AI, które wykorzystują poufne dane.

- Kontrolę w zakresie prywatności danych, bezpieczeństwa, przejrzystości i governance.

- Chmurę z funkcjami ITOps i AIOps w celu zwiększenia produktywności.

- Szybką ścieżkę do użytkowania, pozwalającą przygotować się na przyszły rozwój AI i związanych z nią możliwości.

Głęboko zintegrowana technologia

Podstawą proponowanego stosu oprogramowania do AI i danych jest platforma software’owa NVIDIA AI Enterprise. Zawiera ona również mikrousługi wnioskowania NVIDIA NIM. Wspomniana platforma odpowiada za przyspieszenie analizy danych, usprawnienie opracowywania i wdrażania do produkcji co-pilotów oraz innych zastosowań GenAI. Z kolei NVIDIA NIM dostarcza mikrousługi optymalizujące wydajność wnioskowania i zapewniające płynne przejście od prototypu do wdrożenia produkcyjnego modeli AI.

Uzupełnieniem dla NVIDIA AI Enterprise i NVIDIA NIM jest natomiast oprogramowanie HPE AI Essential. To gotowy do użycia zestaw wyselekcjonowanych narzędzi do AI i danych. Zapewniają one elastyczne rozwiązania, ciągłe wsparcie oraz usługi. Przykładowo, takie jak compliance dla danych i modeli czy funkcje zapewniające zgodność, przejrzystość oraz powtarzalność w całym cyklu życia AI.

HPE Private Cloud AI zapewnia w pełni zintegrowany stos infrastruktury dla AI. W tym:

- rozwiązanie sieciowe NVIDIA Spectrum-X Ethernet,

- HPE GreenLake for File Storage,

- serwery HPE ProLiant ze wsparciem dla platform NVIDIA L40S, NVIDIA H100 NVL Tensor Core i GH200 NVL2.

Doświadczenie chmurowe bazujące na HPE GreenLake

HPE Private Cloud AI bazuje na HPE GreenLake. Usługi w tej chmurze zapewniają zarządzalność i obserwowalność, co pozwala na automatyzację, orkiestrację i zarządzanie punktami końcowymi, obciążeniami roboczymi oraz danymi w środowiskach hybrydowych. Obejmują one m.in. wskaźniki zrównoważonego rozwoju dla obciążeń roboczych i punktów końcowych.

HPE Private Cloud AI wykorzystuje kopilota AI OpsRamp, którego działanie zintegrowano właśnie z HPE GreenLake, aby zapewnić obserwowalność i AIOps dla wszystkich produktów i usług HPE. OpsRamp zapewnia obserwowalność dla całego stosu obliczeniowego NVIDIA. W tym dla oprogramowania NVIDIA NIM i AI, procesorów graficznych NVIDIA Tensor Core i klastrów AI, a także dla przełączników NVIDIA Quantum InfiniBand i NVIDIA Spectrum Ethernet. Kopilot OpsRamp wykorzystuje platformę obliczeniową NVIDIA do interpretacji dużych zestawów danych. Jej wyniki są prezentowane przez asystenta konwersacyjnego. Jak poinformowano, OpsRamp będzie również zintegrowany z interfejsami API CrowdStrike.

Rozszerzenie współpracy z integratorami

Wszystkie produkty i usługi wchodzące w skład NVIDIA AI Computing by HPE zostaną wprowadzone na rynek w ramach wspólnej strategii. Obejmuje ona zespoły sprzedażowe i partnerów handlowych, szkolenia oraz globalną sieć integratorów systemów.

Wsparcie dla NVIDIA AI Computing by HPE i HPE Private Cloud AI, ogłosiły następujące firmy: Deloitte, HCLTech, Infosys, TCS i WIPRO.

Jak zapowiedziano, rozwiązanie HPE Private Cloud AI ma być powszechnie dostępne jesienią 2024 roku.

Obsługa nowych superchipów NVIDIA

HPE dodało też obsługę najnowszych GPU, CPU oraz superchipów NVIDIA. Jak poinformowano:

- HPE Cray XD670 obsługuje osiem procesorów graficznych NVIDIA H200 NVL Tensor Core – wskazywany jest dla twórców LLM (dostępność latem 2024).

- Serwer HPE ProLiant DL384 Gen12 z NVIDIA GH200 NVL2 – dedykowano dla użytkowników LLM korzystających z dużych modeli i RAG (dostępność jesienią 2024 roku).

- Serwer HPE ProLiant DL380a Gen12 obsługuje do ośmiu procesorów graficznych NVIDIA H200 NVL Tensor Core – zaadresowano go dla użytkowników LLM potrzebujących elastycznej skalowalności obciążeń roboczych GenAI (dostępność jesienią 2024 roku).

- HPE będzie wspierać NVIDIA GB200 NVL72 / NVL2 oraz nowe architektury NVIDIA Blackwell, NVIDIA Rubin i NVIDIA Vera.