AdvertorialSztuczna inteligencjaPREZENTACJA PARTNERA

HPE Private Cloud AI jako odpowiedź na wyzwania związane z wdrażaniem AI w polskich firmach

ADVERTORIAL

Największymi wyzwaniami dla polskich organizacji zainteresowanych wykorzystaniem możliwości sztucznej inteligencji pozostają kwestie związane z ochroną, dostępnością oraz jakością danych; potrzebą stworzenia własnych rozwiązań AI, a także kontrolą kosztów oraz ograniczeniem oddolnego, niekontrolowanego wykorzystania takich narzędzi i ograniczeniem ryzyka wykorzystania GenAI.

Wyniki ankiety przeprowadzonej przez redakcję ITwiz wśród polskich średnich i dużych firm wskazują na kluczowe wyzwania i oczekiwania technologiczne w zakresie projektów ukierunkowanych na wykorzystanie potencjału AI. I tak, wnioski z badania przeprowadzonego na zlecenie HPE i NVIDIA pozwalają sądzić, że osoby odpowiedzialne za środowiska IT w polskich firmach w świadomy sposób podchodzą do wyzwań związanych z bezpieczeństwem i ochroną danych wrażliwych.

Bezpieczeństwo i kontrola nad danymi to priorytet

Priorytetowo traktowane są m.in. kwestie związane z ochroną danych, co w kontekście projektów AI nabiera nowego wymiaru. Potrzeba zapewnienia faktycznej kontroli nad danymi, pełnej jurysdykcji nad ich przetwarzaniem oraz ograniczenia do minimum ryzyka ich wycieków – a co za tym idzie także ewentualnych skutków regulacyjnych – wpływa na istotne ograniczenie możliwości wykorzystania publicznie dostępnych usług oraz modeli AI.

Większość, bo 64% ankietowanych decydentów technologicznych podkreśliła, że zależy im na zapewnieniu pełnej i bezkompromisowej kontroli nad firmowymi danymi, które miałyby zasilać modele AI – zwłaszcza w przypadku danych uznanych za wrażliwe.

Za kluczowe uznali pełną kontrolę nad danymi i poziomem ich bezpieczeństwa lub za ważne wymagania dotyczące kontroli i bezpieczeństwa, choć w ich organizacjach – na potrzeby realizacji projektów AI – dopuszczalne jest wykorzystanie zewnętrznych rozwiązań i zasobów.

Jednocześnie, jeden na pięciu badanych z tego grona godzi się na ograniczenie tych wymagań tylko do danych wrażliwych. Alternatywne, nieco mniej popularne podejście zakłada natomiast dążenie do zachowania równowagi pomiędzy kontrolą nad danymi a innowacyjnością.

Uruchomienie AI w lokalnym, w pełni kontrolowanym środowisku

W tym kontekście duże znaczenie ma charakterystyka platformy HPE Private Cloud AI, która zapewnia rozbudowane funkcje związane z bezpieczeństwem i zapewnieniem zgodności z regulacjami branżowymi, a także model działania gwarantujący lokalne przetwarzanie całości danych oraz obciążeń aplikacyjnych.

Obejmuje to także możliwość lokalnej obsługi obciążeń wykorzystujących sztuczną inteligencję we w pełni kontrolowanym środowisku, gdzie ryzyko wycieku wrażliwych danych jest znacząco ograniczone. Takie podejście pozwala zbudować w niezależną, suwerenną względem zewnętrznych dostawców infrastrukturę AI. Jednocześnie zaś – za sprawą łatwej dostępności całego stosu technologii niezbędnych do zapewnienia efektywności i skalowalności obciążeń opartych na sztucznej inteligencji – HPE Private Cloud AI pozwala na pełną swobodę w dostosowywaniu, wdrażaniu oraz obsługi obciążeń AI.

Tego typu mechanizmy mogą okazać się szczególnie przydatne w branżach regulowanych, jak finanse, ochrona zdrowia czy administracja publiczna, ale także dla organizacji zainteresowanych zasileniem modeli AI własnymi, wrażliwymi danymi.

Ograniczone zaufanie do chmury publicznej

Aż 78% ankietowanych zgodziło się ze stwierdzeniem (odpowiedzi zdecydowanie tak lub raczej tak), że rozwiązania działające w modelu on-premise zapewniają większą pewność ochrony własności intelektualnej i wrażliwych informacji niż te uruchomione w ramach środowisk publicznej chmury obliczeniowej. Odmiennego zdania jest 17% uczestników badania.

W przypadku środowisk publicznej chmury obliczeniowej powszechnie poddawana pod dyskusję jest kwestia nadmiernego przywiązania do usług jednego dostawcy. Na tym tle przewagę zyskują rozwiązania zapewniające komplet technologii i zasobów potrzebnych do obsługi AI w ramach lokalnego środowiska klienta.

Przykładowo, platforma HPE Private Cloud AI zapewnia łatwy dostęp do narzędzi rozwijanych na zasadzie open source, w tym środowisk JupyterLab, Apache Spark czy Apache Airflow, ale też wstępnie przeszkolonych i zoptymalizowanych pod kątem działania w środowisku NVIDIA AI Enterprise modeli AI, jak LLaMA 3. Uzupełnieniem tych możliwości są też łatwe w dostosowaniu szablony użycia wspomnianych modeli AI.

Za sprawą narzędzi HPE AI Essentials możliwe jest także łatwe wykorzystanie własnych lub publicznych modeli AI, a także ich dotrenowanie pod kątem potrzeb lub preferencji danej organizacji. Takie podejście pozwala skrócić czas realizacji projektów opartych na AI.

Skalowalność od projektu do produkcji

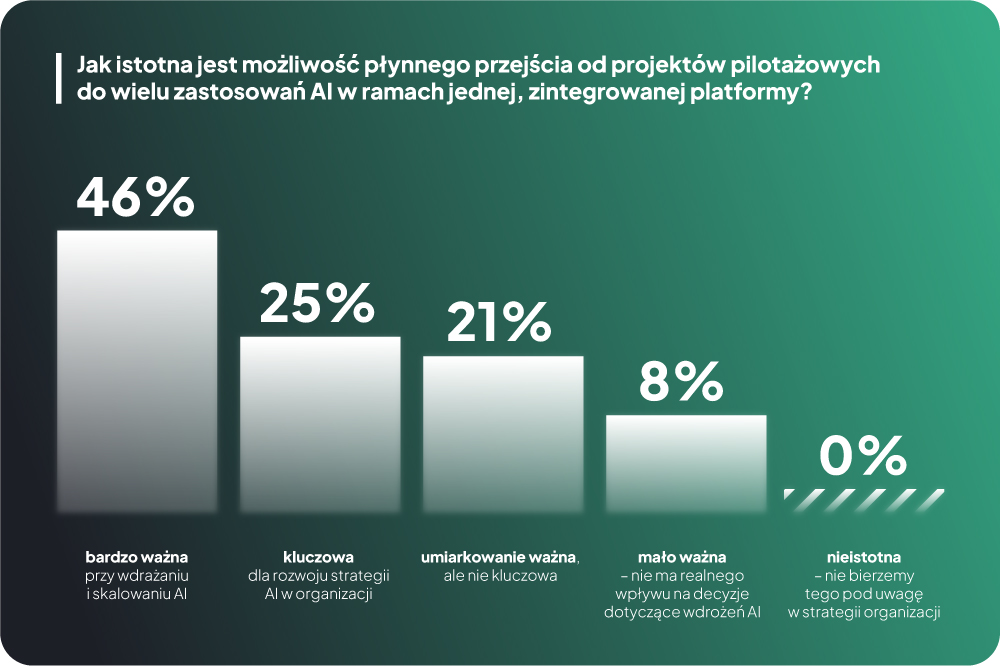

Co nie mniej istotne, dla większości ankietowanych istotna jest możliwość sprawnego przejścia od projektów pilotażowych do produkcyjnych zastosowań AI w ramach jednej, zintegrowanej platformy sprzętowo-aplikacyjnej.

W przypadku oferty HPE kluczowe znaczenie ma tu standaryzacja i integracja w ramach platformy HPE Private Cloud AI wiodących rozwiązań dedykowanych do obsługi AI, w tym układów GPU firmy NVIDIA czy narzędzi wspierających zarządzanie cyklem życia modeli uczenia maszynowego.

Co nie mniej istotne, oferta HPE obejmuje także rozwiązania upraszczające wdrażanie i bieżącą obsługę projektów AI, w tym dwa stacki technologiczne (NVIDIA AI Enterprise oraz HPE AI Essential Software). Daleko idąca integracja i standaryzacja technologiczna, a także szerokie możliwości automatyzacji oznaczają możliwość realizacji projektów biznesowych przy minimalnym zaangażowaniu IT w codzienne zadania związane z utrzymaniem środowiska.

Zastosowanie zintegrowanych rozwiązań zapewniających cały stos technologii niezbędnych do wdrażania i używania sztucznej inteligencji w środowiskach biznesowych za kluczowe dla rozwoju strategii AI w organizacji lub ważne przy wdrażaniu i skalowaniu AI uznało 70% badanych. Pozwala im to bowiem na płynne przejście od projektów pilotażowych do wielu zastosowań AI w ramach jednej, zintegrowanej platformy.

Za umiarkowanie ważne takie rozwiązania uznaje jeden na pięciu badanych, a tylko co dziesiąty twierdzi, że wykorzystanie zintegrowanych platform technologicznych nie ma w ich organizacjach realnego wpływu na decyzje dotyczące wdrożeń AI. Decydujące znaczenie ma tu zapewne możliwość precyzyjnego dopasowania technologii oraz modeli AI do faktycznych potrzeb danej organizacji.

Samodzielność otwarta na współpracę

Około jednej piątej ankietowany (22%) zapewnia, że w jego organizacji preferowane jest podejście zakładające tworzenie własnych rozwiązań AI z dostępnych na rynku komponentów. Dla podobnej grupy ankietowanych istotnym kryterium wyboru całej platformy technologicznej są: uproszczone wdrożenie AI i szybkie efekty biznesowe.

Niezależnie od tego, ponad 90% ankietowanych deklaruje zainteresowanie współpracą – w różnym zakresie i na różnym etapie projektu – z dostawcami zapewniającymi doradztwo w procesie kształtowania strategii AI oraz faktycznej realizacji wdrożeń. Z kolei co czwarty badany zapewnia o otwartości na długofalową współpracą z partnerem technologicznym, także w zakresie kompleksowego wsparcia merytorycznego.

Jeden na dziesięciu ankietowanych liderów technologicznych deklaruje natomiast, że w ich organizacji partnerstwo tego rodzaju jest istotne w kontekście całego cyklu życia projektów AI. Jednocześnie, badanie pozwala sądzić, że w 1 na 10. organizacji projekty AI będą realizowane w sposób samodzielny, bez zewnętrznego doradztwa. Około 13% organizacji chce korzystać ze wsparcia merytorycznego tylko na etapie planowania projektów AI.

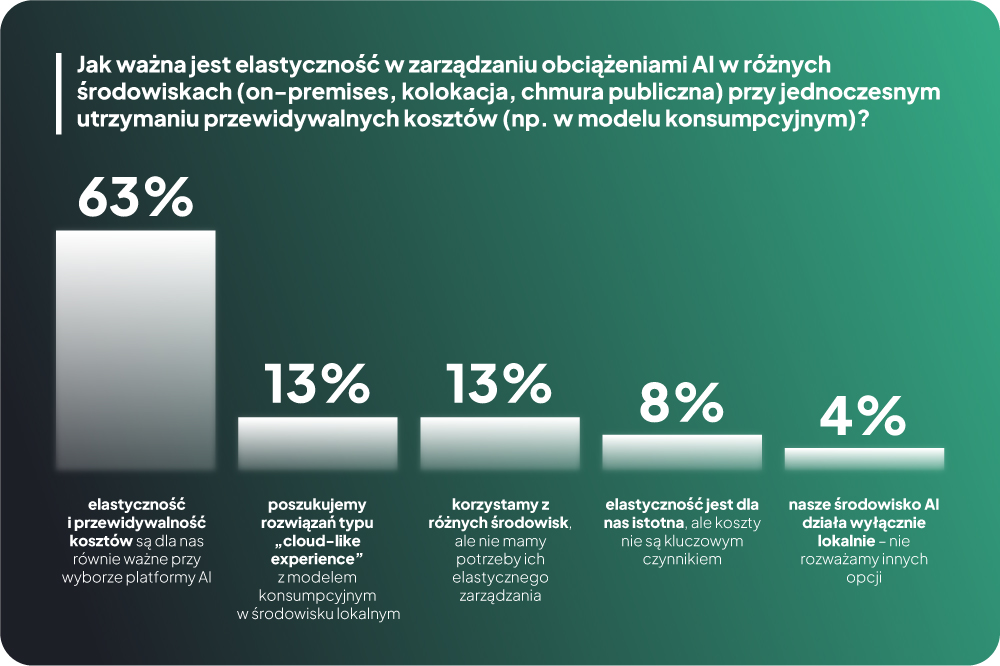

Platforma technologiczna, czyli elastyczność i kontrola kosztów

Dla ponad 60% uczestników badania, kluczowymi cechami platformy technologicznej dla projektów AI są w równym stopniu elastyczność i przewidywalność kosztów użycia. Dla prawie 10% istotna jest elastyczność, ale koszty nie są już kluczowym czynnikiem.

Ponad 10% badanych deklaruje, że w ich organizacji – na rzecz projektów AI – wykorzystywane są różne środowiska. Jednak potrzeba elastycznego zarządzania nimi nie jest istotna. Tyle samo organizacji poszukuje środowisk typu Cloud-Like Experience z modelem konsumpcyjnym, ale działających w środowisku lokalnym. Tylko niewielka grupa organizacji (poniżej 5%) planuje realizację projektów AI wyłącznie w oparciu o lokalne, posiadane na własność zasoby i nawet nie rozważa wykorzystania innych opcji lub modeli pozyskania potrzebnych zasobów w innych modelach.

Na tym tle korzystnie wypada podejście proponowane przez firmę HPE. Dzięki modelowi pay-as-you-go przedsiębiorstwa mają pełną kontrolę nad wydatkami, a infrastruktura może być dostosowywana do rzeczywistych potrzeb projektów AI bez znaczących inwestycji kapitałowych.

Ponadto, platforma HPE Private Cloud AI zapewnia możliwość wykorzystania uruchomionych lokalnie, w centrum danych klienta, zasobów w modelu analogicznym do usług publicznej chmury obliczeniowej, ale przy zachowaniu całkowitej kontroli nad całym stosem technologicznym, danymi oraz modelami AI.

Co więcej, propozycja HPE odpowiada też na potrzebę optymalizacji kosztów użycia AI. Platforma HPE Private Cloud AI zapewnia m.in. mechanizmy pozwalające na efektywne zarządzanie wykorzystaniem energochłonnych zasobów, w tym GPU. Przekłada się to na lepszą kontrolę i możliwość ograniczenia kosztów.

Czym jest HPE Private Cloud AI?

Platforma HPE Private Cloud AI to ustandaryzowana, prywatna chmura obliczeniowa, zaprojektowana jako fundament wdrożeń projektów sztucznej inteligencji w przedsiębiorstwach. Jako rozwiązanie rozwijane przez firmę Hewlett Packard Enterprise we współpracy z NVIDIA, zapewnia pełną kontrolę nad danymi oraz środowiskiem AI, oferując jednocześnie skalowalność, elastyczność i bezpieczeństwo.

Istotą platformy HPE Private Cloud AI jest daleko idąca integracja sprzętu, oprogramowania i usług. W warstwie sprzętowej bazuje platforma ta bazuje na serwerach HPE ProLiant z wyposażonymi w wydajne, przeznaczone do obsługi obciążeń AI układy GPU firmy NVIDIA – H100, H200 lub RTX PRO 6000, a także zaawansowane rozwiązania sieciowe gwarantujące najwyższą szybkość transmisji wymaganą przez aplikacje AI. Integralną częścią platformy HPE Private Cloud AI są również narzędzia HPE AI Essentials i NVIDIA AI Enterprise, które zapewniają ułatwienia w realizacji projektów AI w sposób zgodny z regulacjami, a także wspierają m.in. automatyzację, monitoring i zarządzanie modelami AI.

Dlaczego HPE Private Cloud AI?

Charakterystyka platformy HPE Private Cloud AI dobrze wpisuje się w potrzeby deklarowane przez uczestników badania ankietowego ITwiz m.in. w zakresie bezpieczeństwa, kontroli nad danymi, skalowalności projektów AI, ale też elastyczności kosztowej. Platforma ta, zapewniając kompletne, zintegrowane środowisko do realizacji projektów AI pozwala redukować ryzyka i przyspieszać adopcję opartych na sztucznej inteligencji aplikacji w rzeczywistych scenariuszach biznesowych.

Jednocześnie, wbudowane optymalizacje przekładają się na poprawę wydajności sztucznej inteligencji AI. Według szacunków producenta działające na platformie HPE Private Cloud AI modele AI zyskują nawet czterokrotnie szybsze wnioskowanie i pięciokrotnie wyższą efektywność, w porównaniu z infrastrukturą ogólnego zastosowania. W efekcie, według danych HPE, pod względem kosztowym wdrożenia AI oparte na platformie HPE Private Cloud AI mają być nawet o 60% tańsze niż w publicznej chmurze oraz o połowę tańsze w porównaniu do budowy własnej infrastruktury AI.

Dla kogo HPE Private Cloud AI?

Uniwersalność, nastawienie na bezpieczeństwo danych, a także skalowalność i otwartość technologiczna platformy HPE Private Cloud AI przekładają się na szerokie możliwości jej wykorzystania w różnych branżach. Możliwe scenariusze użycia obejmują m.in. sektor finansów (automatyzacja scoringu, wykrywanie nadużyć), ochronę zdrowia (analiza obrazów, diagnostyka), administrację publiczną (przetwarzanie zgłoszeń, automatyzacja procesów), handel detaliczny (analiza zachowań klientów, dynamiczna optymalizacja cen), telekomunikację (predykcja awarii, zarządzanie infrastrukturą) i sektor produkcyjny (monitorowanie procesów, kontrola jakości, przewidywanie awarii).