Sztuczna inteligencjaRynek

OpenAI udostępnia modele gpt-oss: lżejsze, otwarte i gotowe do lokalnych wdrożeń

Mowa o gpt-oss-120b i gpt-oss-20b, które zaprojektowano z myślą o lokalnym wdrażaniu, niskich kosztach operacyjnych i maksymalnej elastyczności. Modele udostępniono na licencji Apache 2.0, co daje programistom i firmom pełną swobodę wykorzystania, dostrajania i uruchamiania ich we własnym środowisku.

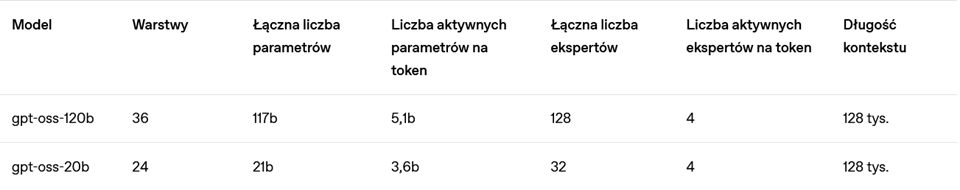

gpt-oss-120b (117 mld parametrów) działa na pojedynczej karcie GPU z 80 GB pamięci i osiąga wydajność zbliżoną do GPT-4o mini. Z kolei gpt-oss-20b (21 mld parametrów) można uruchomić na sprzęcie z 16 GB RAM. Oba modele są dostępne bezpłatnie w serwisie Hugging Face i obsługują natywną kwantyzację MXFP4, która znacząco obniża wymagania sprzętowe.

Modele dostrojono z użyciem formatu poleceń Harmony, a OpenAI udostępniło open-source’owy Harmony renderer w językach Python i Rust. Wraz z modelami zapewniono też implementacje referencyjne dla PyTorch i Apple Metal, a także zestaw narzędzi wdrożeniowych.

Elastyczne wdrożenia

W ramach partnerstw wdrożeniowych, modele gpt-oss można uruchamiać za pośrednictwem platform takich jak: Hugging Face, Azure, AWS, vLLM, llama.cpp, LM Studio, OpenRouter, Cloudflare czy Vercel. A także lokalnie lub na urządzeniu końcowym. Współpraca z producentami sprzętu – NVIDIA, AMD, Cerebras, Groq – zapewnia z kolei szeroką optymalizację pod kątem różnych środowisk.

Dodatkowo, Microsoft udostępnił zoptymalizowane wersje modelu gpt-oss-20b dla Windows, wykorzystujące ONNX Runtime, z obsługą lokalnego wnioskowania przez Foundry Local i AI Toolkit dla VS Code. To krok w stronę demokratyzacji lokalnego przetwarzania AI na popularnych platformach programistycznych.

Architektura MoE i wyniki benchmarków

gpt-oss wykorzystuje architekturę Mixture of Experts – aktywowanych jest tylko 5,1 mld lub 3,6 mld parametrów, co zwiększa efektywność działania bez utraty jakości. W testach porównawczych (m.in. TauBench, HealthBench, Codeforces, AIME) modele wypadają na poziomie zamkniętych odpowiedników OpenAI, przewyższając je w niektórych kategoriach.

Przedstawiciele OpenAI podkreślają, że gpt-oss to propozycja dla tych, którzy potrzebują pełnej kontroli nad modelem i infrastrukturą. Użytkownicy wymagający funkcji multimodalnych, gotowych integracji i rozwiązań no-code mogą nadal korzystać z modeli udostępnianych przez API. W przyszłości OpenAI rozważy również udostępnienie gpt-oss przez własny interfejs API.

KOMENTARZ EKSPERTA

Publikacja modeli gpt-oss z otwartymi wagami to jeden z najważniejszych momentów w tegorocznej dyskusji o kierunku rozwoju AI. Ten krok nie jest tylko gestem w stronę środowiska open source – to realna zmiana zasad gry dla firm, które dotychczas ostrożnie podchodziły do generatywnej sztucznej inteligencji.

Dotąd wiele organizacji, szczególnie z sektora średnich i dużych przedsiębiorstw technologicznych, miało dwa poważne ograniczenia: brak pełnej kontroli nad danymi i wysoką zależność od dostawców chmurowych. Otwarte wagi rozwiązują oba te problemy. Pozwalają uruchamiać i trenować modele w środowisku on-premises lub w chmurach prywatnych, zachowując pełną poufność danych i swobodę w dostosowywaniu architektury do konkretnych wymagań biznesowych.

W praktyce oznacza to, że polskie firmy mogą teraz:

- tworzyć wewnętrznych asystentów AI, którzy korzystają wyłącznie z własnych, zatwierdzonych źródeł wiedzy,

- integrować modele z systemami CRM, ERP czy platformami e-commerce,

- budować dedykowane rozwiązania branżowe, np. dla finansów, medycyny, prawa czy produkcji, bez ryzyka, że dane „uciekną” poza organizację.

W marketingu i sprzedaży otwarte modele mogą automatyzować personalizację komunikacji, generować oferty w oparciu o historię współpracy czy wspierać zespoły w analizie danych rynkowych. W HR – od inteligentnego przeszukiwania CV i dopasowywania kandydatów, po chatboty rekrutacyjne odpowiadające na pytania zgodnie z aktualnymi procedurami. W obszarze obsługi klienta – automatyczne, spójne i zgodne z polityką firmy odpowiedzi w wielu kanałach jednocześnie.

Ten ruch OpenAI jest katalizatorem. Obniża barierę wejścia w AI, daje narzędzia do eksperymentowania bez gigantycznych opłat licencyjnych i pozwala budować przewagę konkurencyjną w oparciu o to, co firma już ma – swoje dane, know-how i unikalny model działania. Jeżeli polskie firmy wykorzystają tę szansę, możemy spodziewać się przyspieszenia transformacji cyfrowej w tempie, którego dotąd nie widzieliśmy.

Arkadiusz Seredyn, Vice President w RITS Professional Services, ekspert w zakresie transformacji cyfrowej, technologii marketingowych i sztucznej inteligencji.