Sztuczna inteligencjaAplikacjeRynek

Czy Nightshade skutecznie „zatruje” szkolenie modeli AI?

Naukowcy z University of Chicago stworzyli darmowe narzędzie Nightshade, które przekształca dowolny obraz w „zatrutą” próbkę danych, nienadającą się do szkolenia modeli AI. Innymi słowy, Nightshade psuje dane treningowe w taki sposób, który może spowodować poważne uszkodzenie modeli sztucznej inteligencji generujących obrazy. Ma to być skuteczna „broń” w walce z firmami zajmującymi się sztuczną inteligencją, które wykorzystują prace artystów do trenowania swoich modeli bez ich zgody. W niecały tydzień po uruchomieniu, oprogramowanie pobrano ponad 250 000 razy.

Narzędzie Nightshade może pomóc powstrzymać trenerów modeli AI, którzy lekceważą prawa autorskie, listy opt-out i dyrektywy do-not-scrape/robots.txt. Użycie go do „zatrucia” danych treningowych może uszkodzić przyszłe iteracje modeli generujących obrazy, takich jak DALL-E, Midjourney i Stable Diffusion. Jak podkreślają twórcy Nightshade, celem narzędzia nie jest jednak złamanie takich modeli, a zwiększenie kosztów szkolenia na nielicencjonowanych danych, tak aby licencjonowanie obrazów od ich twórców stało się realną alternatywą. Firmy zajmujące się sztuczną inteligencją, takie jak OpenAI, Meta czy Google, stają zatem w obliczu wielu pozwów ze strony artystów, którzy twierdzą, że ich materiały chronione prawem autorskim zostały wykorzystane bez ich zgody lub rekompensaty.

Jak działa Nightshade?

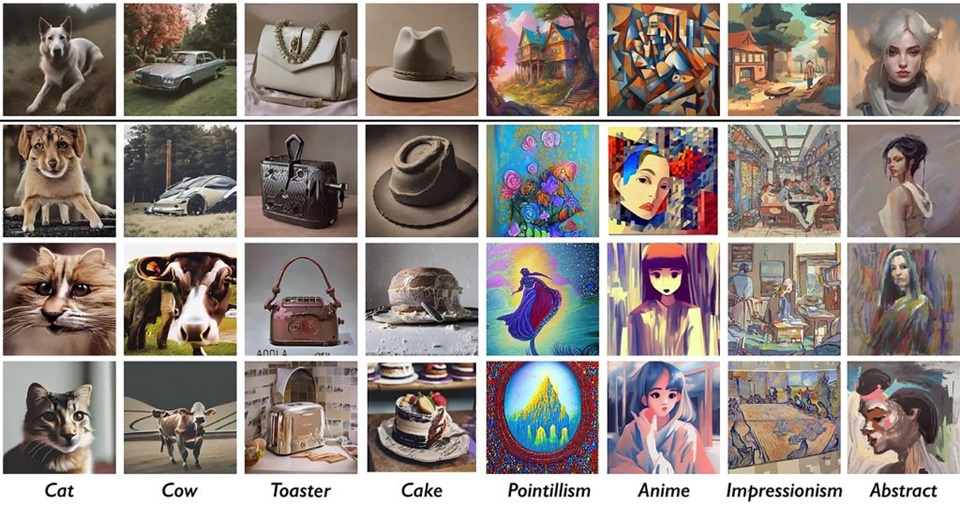

Nightshade wykorzystuje lukę w zabezpieczeniach generatywnych modeli sztucznej inteligencji, wynikającą z faktu, że są one szkolone na ogromnych ilościach danych – w tym przypadku obrazów pobranych z internetu. Narzędzie to umożliwia artystom dodawanie niewidocznych zmian do pikseli w ich dziełach, przed przesłaniem ich do internetu. Podczas gdy ludzkie oczy widzą zacieniony obraz, który jest w dużej mierze niezmieniony w stosunku do oryginału, model AI widzi z kolei radykalnie inną kompozycję. Przykładowo, podczas gdy ludzkie oczy zobaczą zacieniony ale niezmieniony obraz krowy na zielonym polu, model AI może zobaczyć już dużą skórzaną torebkę leżącą w trawie. I tak, wyszkolony na wystarczającej liczbie zacienionych obrazów, które zawierają krowę, model będzie przekonany, że krowy mają ładne brązowe skórzane uchwyty i gładkie boczne kieszenie z zamkiem błyskawicznym.

Oprogramowanie to działa podobnie do narzędzia Glaze, ale zamiast obrony przed naśladownictwem stylu, zaprojektowano je jako narzędzie ofensywne do zniekształcania reprezentacji funkcji w generatywnych modelach obrazu AI. Glaze zatem powinien być używany na każdym dziele, które artyści publikują online, aby chronić siebie, podczas gdy Nightshade stosuje się do odstraszania trenerów modeli AI. Artyści, którzy publikują własne prace w internecie, powinni więc stosować zarówno Glaze, jak i Nightshade. Eksperci z uniwersytetu w Chicago pracują zresztą nad zintegrowaną wersją obu tych narzędzi.

Podobnie jak w przypadku Glaze, efekty Nightshade są odporne na normalne zmiany, które można zastosować do obrazu. Można go więc dowolnie przyciąć, ponownie próbkować, skompresować, wygładzić piksele lub dodać szum, a efekty pozostaną te same. Można nawet zrobić zrzuty ekranu czy zdjęcie obrazu wyświetlanego na monitorze – dzieje się tak, ponieważ nie jest to znak wodny ani ukryta wiadomość (steganografia).