Branża ITCyberbezpieczeństwoSztuczna inteligencjaPolecane tematy

Bielik przedstawia Sójkę: polski lekki model do moderowania treści cyfrowych

Bielik.AI udostępnia pierwszą wersję Bielik Guard czyli „Sójki”, modelu sztucznej inteligencji zaprojektowanego do wykrywania toksycznych treści w komunikacji cyfrowej. To jedno z pierwszych w Polsce narzędzi typu guardrails, działające w czasie rzeczywistym i gotowe do integracji z aplikacjami, serwisami społecznościowymi czy chatbotami.

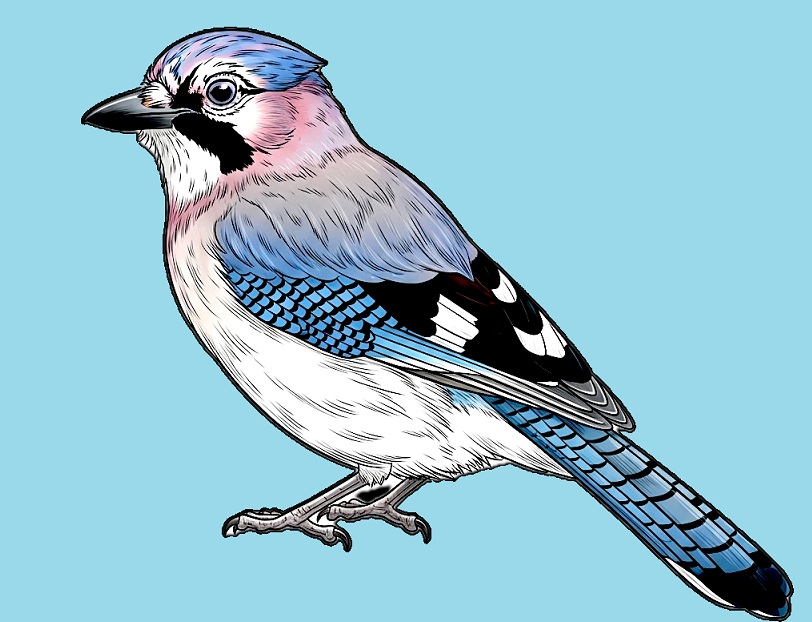

Projekt Sójka powstawał jako odpowiedź na narastający problem hejtu, wulgaryzmów czy przemocy słownej w internecie, dzięki pracy zespołu ze społeczności Speak Leash, ale także zaangażowaniu społeczności. Ponad 1500 osób wypełniło 65 tys. ankiet, pomagając zespołowi w przygotowaniu danych treningowych i wskazując treści, które nie powinny być publikowane. Dzięki temu model lepiej rozpoznaje zagrożenia obecne w sieci – od hejtu i wulgaryzmów, po treści seksualne, instrukcje przestępcze czy samookaleczenia. Jego wielką zaletą jest dostosowanie do polskiego kontekstu kulturowego i języka. Nazwa projektu nawiązuje oczywiście do obyczajów tego barwnego ptaszka, który głośnym skrzeczeniem ostrzega przed pojawieniem się niebezpieczeństwa; dobrze też naśladuje inne ptaki a nawet inne zwierzęta – co ilustruje cecha kontekstowości modelu.

Sójkowe podejście do treści cyfrowych

„Sójka” to model regresyjny, który pozwala wychwycić nie tylko treści jednoznacznie szkodliwe, ale także te sytuujące się na granicy, tam, gdzie zwykłe algorytmy często zawodzą.

Fundamentem Bielik Guard są jasno zdefiniowane filary bezpieczeństwa. Model sprawdza treści pod kątem pięciu najgroźniejszych obszarów: mowy nienawiści, wulgaryzmów, treści seksualnych, instrukcji przestępczych oraz zachowań autodestrukcyjnych. To właśnie te kategorie stanowią rdzeń projektu i pozwalają skutecznie odróżniać to, co neutralne, od tego, co realnie zagraża użytkownikom.

Projekt wyróżnia podejście do anotacji. Każdy tekst może być oznaczony w więcej niż jednej kategorii, jeśli łączy w sobie różne formy toksyczności. Ważne są również wspomniane przypadki graniczne – sytuacje, które budzą wątpliwości. To właśnie na nich model uczy się subtelnych różnic i społecznych odcieni wrażliwości. Różnorodność ocen nie jest tu traktowana jako błąd, lecz jako wartość, która wzmacnia skuteczność rozwiązania.

To eksperymentalny projekt o dużym potencjale. Jego rezultaty mogą znaleźć zastosowanie nie tylko w sektorze nowych technologii, ale również w edukacji, mediach czy administracji publicznej. Wspólnym celem jest jedno – budowanie bezpieczniejszego środowiska cyfrowego, w którym wolność słowa nie oznacza przyzwolenia na toksyczność.

Dlaczego Bielik zaprosił Sójkę?

Według badania NASK co drugi nastolatek w Polsce doświadczył przemocy w sieci, a aż 7 na 10 młodych ludzi wskazuje hejt jako jeden z największych problemów internetu. „Najbardziej przerażające jest to, że większość ofiar przemocy seksualnej online milczy i pozostaje z problemem zupełnie sama” – mówi Jan Maria Kowalski, ekspert AI, współtwórca Sójki, który jest lider projektu prowadzonego w ramach Speak Leash. „Sójka powstała właśnie w odpowiedzi na te realne problemy. To projekt, który łączy technologię AI z zaangażowaniem społeczności – dzięki temu możemy chronić użytkowników, wspierać moderatorów i tworzyć bezpieczniejszą przestrzeń, szczególnie dla młodszych internautów, którzy są najbardziej narażeni na toksyczne treści” – dodaje.

Jak zaznacza inny współtwórca Sójki, Krzysztof Wróbel, posiada ona szereg przewag nad innymi tego typu rozwiązaniami. „Sójka została zaprojektowana jako lekki, wydajny model możliwy do uruchomienia nawet na zwykłym komputerze, bez kosztownych serwerów z kartami graficznymi (GPU). Dzięki temu mogą z niej korzystać organizacje i instytucje publiczne, które nie dysponują rozbudowaną infrastrukturą techniczną. Warto również podkreślić, że zamiast narzucać jedną definicję toksycznych treści, model zwraca prawdopodobieństwo przypisania tekstu do każdej kategorii. Dzięki temu użytkownicy i moderatorzy mogą samodzielnie ustawiać progi wykrywania toksycznych i niebezpiecznych treści, dostosowując działanie Sójki do swoich wartości i potrzeb” – wyjaśnia Krzysztof Wróbel. W odróżnieniu od niej, wiele innych rozwiązań przypisuje co najwyżej jedną kategorię, z kolei wielojęzyczne rozwiązania reprezentują często anglocentryczne punkt widzenia, nie odpowiadający różnym systemom wartości, które posiadają inne społeczności i kultury.

Lepsze zrozumienie języka polskiego, polskiej kultury starano się uzyskać budując Sójkę w o dane i anotacje uwzględniające realia semantyczne i gramatyczne. Dzięki temu lepiej model lepiej rozumie lokalny kontekst językowy i kulturowy. „Istniejące modele trenowane głównie na danych anglojęzycznych często zawodzą w kontakcie z polską ironią, zawiłością składni czy bogactwem wulgaryzmów. Polski jest językiem fleksyjnym, z wieloma wariantami słów, regionalizmami i kreatywnymi zapisami omijającymi cenzurę (np. „ch***”)” – mówi Dota Szymborska, etyczka nowych technologii.

Bystra Sójka będzie się jeszcze doskonalić

Pierwsza wersja Sójki osiąga już wysoką skuteczność na danych testowych przygotowanych w ramach projektu. Czego zespół spodziewa się po fazie testów? Jak mierzy skuteczność Bielik Guard? „Naszą ambicją jest, by model wykrywał co najmniej 9 na 10 toksycznych treści, jednocześnie ograniczając liczbę fałszywych alarmów, czyli sytuacji, w których niesłusznie klasyfikuje neutralne wypowiedzi jako niebezpieczne” – mówi Krzysztof Wróbel.

Oznacz to, że otwarte pozostaje zaproszenie do szerokiej publiczności do udziału w testach Sójki i zgłaszania uwag. „To właśnie dzięki informacjom zwrotnym – poprzez wskazywanie przykładów, w których Sójka nie zadziałała poprawnie – możemy systematycznie ulepszać model i czynić go coraz bardziej skutecznym” – zaznacza Krzysztof Wróbel.

W intencji jej twórców, Sójka została zaprojektowana jako uniwersalne narzędzie ochrony komunikacji cyfrowej przed szkodliwymi i niebezpiecznymi treściami. Może wspierać platformy edukacyjne, media społecznościowe, fora dyskusyjne, a także czuwać nad komunikacją w czatach. Ważnym polem do zastosowania są szkoły i organizacje pozarządowe. „Szczególną uwagę poświęcamy treściom związanym z samookaleczaniem lub samobójstwami – to narastający problem wśród młodzieży, na który Sójka została zaprojektowana, by być szczególnie wrażliwa” – mówi Jan Maria Kowalski. Jak dodaje: „W takich przypadkach kluczowa jest jednak reakcja platformy internetowej, na której dane treści się pojawiają – to ona odpowiada za podjęcie odpowiednich działań, takich jak wsparcie użytkownika czy wezwanie pomocy”.

O powodzeniu projektu zdecydowało w dużej mierze odwołanie się do społeczności i szeroki odzew. „Społeczność nie tylko pomagała w oznaczaniu danych, ale także dostarczała cennych informacji zwrotnych podczas testów pierwszej wersji modelu – Bielik Guard. To właśnie dzięki ich uwagom mogliśmy poprawić precyzję wykrywania treści i lepiej dopasować działanie modelu do realnych potrzeb użytkowników” – podkreśla Jan Maria Kowalski.

Największym zaskoczeniem dla zespołu była ogromna świadomość uczestników i ich zaangażowanie. „Ludzie podchodzili do zadania odpowiedzialnie, często argumentując swoje wybory i zgłaszając subtelne przypadki, które mogłyby zostać pominięte. To pokazuje, że wspólna praca zespołu i społeczności pozwala tworzyć rozwiązania, które realnie chronią użytkowników internetu, a przy tym edukują i budują świadomość zagrożeń w sieci” – dodaje lider projektu.

Dalsze prace nad Sójką będą prowadzone równolegle w trzech kierunkach: dopracowanie wytycznych i dodanie nowych kategorii (np. dezinformacji) przy wsparciu ekspertów w dziedzinie etyki, dalej rozwój narzędzi do anotacji i poprawa jakości danych oraz eksperymenty z treningiem modeli: zwiększenie precyzji, dodawanie obsługi innych języków, w tym angielskiego, testy wpływu architektury modelu na skuteczność.