Sztuczna inteligencjaInfrastrukturaBranża ITRynekPolecane tematy

Czy nowe procesory NVIDIA Blackwell zrewolucjonizują trenowanie AI?

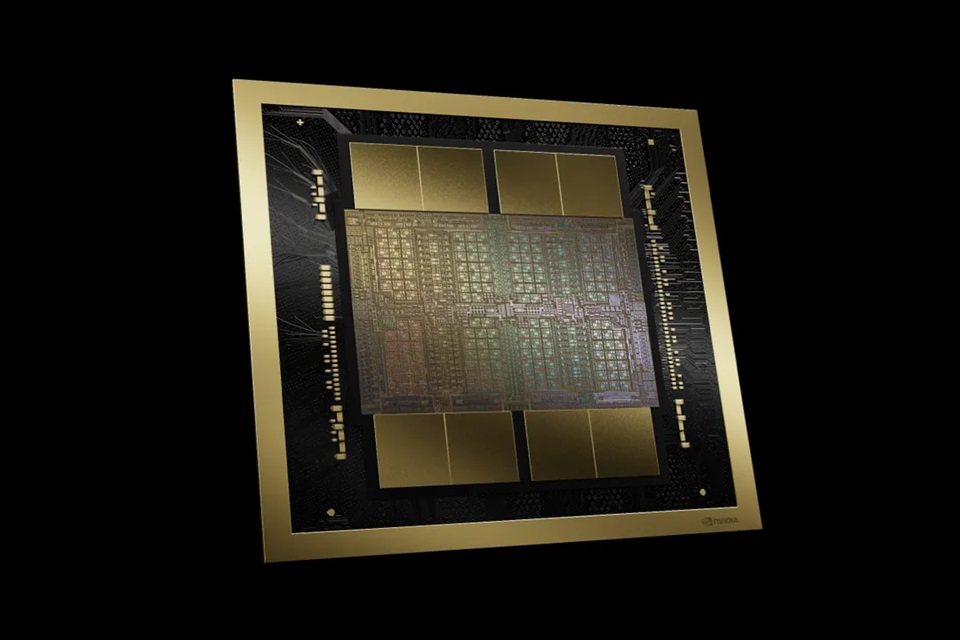

Podczas inauguracji konferencji GTC 2024, Jensen Huang, dyrektor generalny NVIDIA, zaprezentował nowy procesor graficzny Blackwell B200 oraz „superukład” GB200, które mają zapewnić potężny skok jeśli chodzi o moc obliczeniową i trenowanie sztucznej inteligencji.

Szef NVIDIA poinformował, że nowy procesor graficzny B200 oferuje do 20 petaflopów mocy obliczeniowej FP4 dzięki 208 miliardom tranzystorów – dla porównania, poprzedni chip Hopper H100 miał 80 mld tranzystorów i zapewniał maksymalnie 4 petaflopy mocy obliczeniowej AI. B200 oferuje ponadto 8 modułów HBM3e (po 24 GB VRAM każdy) o łącznej pojemności 192 GB, wykorzystującej 8192-bitową magistralę oraz przepustowość sięgającą imponujących 8 TB/s. Procesor został wykonany w niestandardowym procesie litograficznym TSMC 4NP – najprawdopodobniej jest to udoskonalona wersja TSMC 4N.

Układ NVIDIA Blackwell B200 tak naprawdę składa się z dwóch chipletów o powierzchni około 800 mm2, które komunikują się za pomocą magistrali typu die-to-die (TSMC CoWoS-L). Takie rozwiązanie pozwala budować bardziej złożone układy, które w praktyce działają jak jeden układ graficzny.

Jak zapewnia dyrektor generalny koncernu, uczenie modelu o 1,8 biliona parametrów, które wymagałoby wcześniej 8000 procesorów graficznych H100 i 15 megawatów mocy, obecnie zrealizuje 2000 procesorów graficznych Blackwell, zużywając przy tym zaledwie cztery megawaty.

Układ GB200

Podczas konferencji zaprezentowano także układ GB200. Łączy on dwa procesory graficzne B200 z procesorem NVIDIA Grace. GB200 trafi m.in. do systemów obliczeniowych NVIDIA GB200 NVL72, które zaprojektowano z myślą o najbardziej wymagających zadaniach – w jednej szafie serwerowej zainstalowano 36 modułów GB200, co przekłada się na 72 procesory graficzne Blackwell B200 i 36 procesorów Grace, a do tego jednostki przetwarzania danych NVIDIA BlueField-3, które umożliwiają przyspieszenie sieci w chmurze.

Jak stwierdził Jensen Huang, GB200 może zaoferować 30-krotnie wyższą wydajność w przypadku obciążeń związanych z trenowaniem dużych modeli językowych (LLM). „GB200 zmniejsza koszty i zużycie energii nawet 25-krotnie, w porównaniu do H100” – zapewnił.

Rozwiązania oparte o nowe procesory Blackwell mają być dostępne na rynku jeszcze w tym roku. Wiadomo już, że skorzystają z nich największe firmy technologiczne, m.in.: AWS, Dell Technologies, Google, HPE, Meta, Microsoft, OpenAI czy Oracle.

Należy przy tym podkreślić, że układy graficzne Blackwell są jeszcze na etapie prac badawczych i póki co nie wykorzystują pełnego potencjału wydajnościowego.

Powinien powstać C++ 2.0 z lepszą składnią wywalić to #include, std:: dodać println, ponieważ kompilator Rust jest bardzo powolny i ponoć ma jakieś backdoory cały ten LLVM/Clang. W takim nowoczesnym języku jak Odin, V, D, Haxe, Hylo, Vale można pisać bezpieczne sterowniki nvidia. C++ i Rust są brzydkie i mało czytelne.