Sztuczna inteligencjaRynekPolecane tematy

Google prezentuje nowy model AI Gemini 1.5

Jak zapewniają przedstawiciele amerykańskiego koncernu, Gemini 1.5 zapewnia przede wszystkim znacznie większą wydajność, przy jednoczesnym mniejszym zużyciu mocy obliczeniowej niż poprzedni model Gemini 1.0 Ultra. Za większe możliwości w zakresie trenowania nowego modelu Gemini oraz korzystania z niego, odpowiada nowa architektura Mixture-of-Experts (MoE).

Google udostępnia do testów Gemini 1.5 Pro, będący średniej wielkości modelem multimodalnym, zoptymalizowany pod kątem skalowania w szerokim zakresie zadań i działającym na poziomie podobnym do poprzedniego modelu 1.0 Ultra. Gemini 1.5 Pro obejmuje natomiast przełomową, eksperymentalną funkcję rozumienia długiego kontekstu.

Nowy model jest standardowo wyposażony w okno kontekstowe o pojemności 128 tysięcy tokenów, ale ograniczona grupa programistów i partnerów będzie mogła – w ramach wersji przedpremierowej – korzystać z okna kontekstowego o pojemności do nawet miliona tokenów, jako część usługi AI Studio i platformy Vertex AI.

Najważniejsze funkcjonalności Gemini 1.5

- Wysoce wydajna architektura – Gemini 1.5 powstał w oparciu o badania nad architekturą Transformer i MoE. Tradycyjna architektura Transformer działa jak jedna wielka sieć neuronowa, natomiast architektura MoE jest podzielona na mniejsze, wyspecjalizowane sieci neuronowe. W zależności od rodzaju danych wejściowych modele MoE uczą się selektywnie aktywować tylko najbardziej odpowiednie ścieżki w swoich sieciach neuronowych, co znacząco podnosi wydajność modelu. Gemini 1.5 szybciej uczy się więc zdań złożonych przy jednoczesnym utrzymywaniu ich jakości, co sprawia, że trenowanie i korzystanie z niego jest bardziej efektywne.

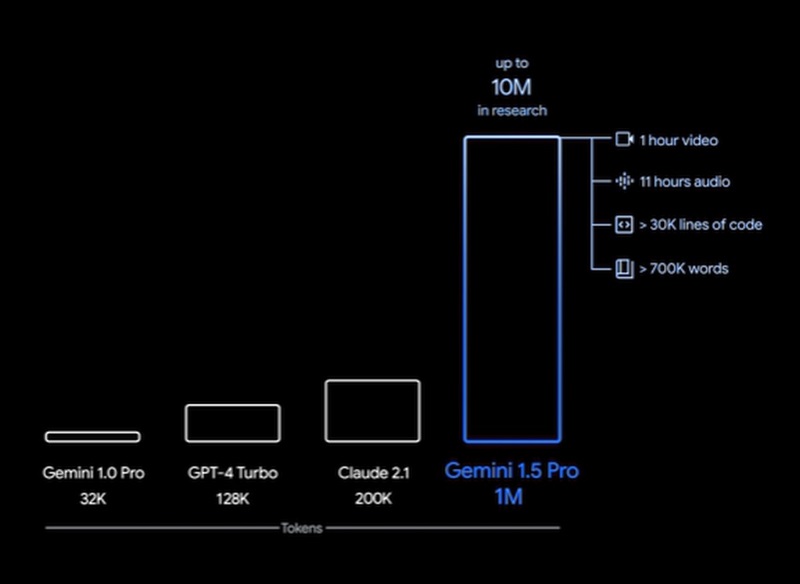

- Szerszy kontekst, bardziej przydatne funkcje. W modelu Gemini 1.5 Pro znacznie zwiększono pojemność okna kontekstowego, która w modelu Gemini 1.0 wynosiła pierwotnie 32 tysiące tokenów. Obecnie można uruchomić do miliona tokenów. Oznacza to, że nowy model jest w stanie przetworzyć przykładowo, 1 godzinę filmu, 11 godzin nagrania dźwiękowego, bazy kodów zawierające ponad 30 tysięcy linijek kodu czy ponad 700 tysięcy słów tekstu. Jak poinformowano, w ramach badań specjalistom Google udało się również przetestować okno kontekstowe o pojemności aż 10 milionów tokenów.

- Rozumienie ogromnych ilości informacji. Model 1.5 Pro potrafi przeanalizować, sklasyfikować i podsumować dużą ilość danych w ramach danego prompta. Przykładowo, po otrzymaniu 402-stronicowej transkrypcji z misji Apollo 11 na Księżyc wyciągnął wnioski na temat rozmów, wydarzeń, obrazów i innych szczegółów znajdujących się w tym dokumencie.

- Lepsze rozumienie różnorodnych typów danych. Gemini 1.5 Pro potrafi wykonywać skomplikowane zadania polegające na przetwarzaniu i rozumieniu różnego rodzaju danych, w tym filmów. I tak, przeanalizował np. różne punkty fabuły i wydarzenia w 44-minutowym niemym filmie Bustera Keatona, a nawet zinterpretował drobne szczegóły filmu, które można łatwo przeoczyć.

- Większa wydajność. Testowana na kompleksowym panelu oceny tekstu, kodu, obrazu, dźwięku i wideo wersja 1.5 Pro przewyższa wersję 1.0 Pro w przypadku 87% testów porównawczych używanych do opracowywania duży modeli językowych (LLM). W porównaniu z wersją 1.0 Ultra w tych samych testach, wydajność jest na podobnym poziomie. Jak zapewniają przedstawiciele Google, Gemini 1.5 Pro wykazuje również imponujące umiejętności „uczenia się w kontekście”, co oznacza, że może nauczyć się czegoś nowego na podstawie informacji podanych w długim prompcie, bez konieczności podawania dodatkowych szczegółów. Przykładowo, po otrzymaniu podręcznika do gramatyki języka kalamang (którym na całym świecie posługuje się mniej niż 200 osób) model uczy się tłumaczyć z języka angielskiego na kalamang, na podobnym poziomie co osoba ucząca się na podstawie tych samych treści.

Etyka i bezpieczeństwo Gemini 1.5

Jak zapewniają specjaliści Google, „każdy z nowych modeli przechodzi szeroko zakrojone testy pod kątem etyki i bezpieczeństwa, a płynące z nich wnioski są włączane do procesów zarządzania oraz opracowywania i oceny modeli, aby stale ulepszać systemy sztucznej inteligencji”. Eksperci koncernu przeprowadzili także nowatorskie badania dotyczące zagrożeń bezpieczeństwa i opracowali testy red teaming w celu określenia różnego rodzaju potencjalnych szkód. „Będziemy nadal poszerzać te testy, między innymi o te, które uwzględniają nowe możliwości długiego okna kontekstowego wersji 1.5 Pro” – poinformowano.

Dostępność nowego modelu

Jak już wspomniano, przedpremierową wersję modelu udostępniono wybranym deweloperom i klientom korporacyjnym w ramach usługi AI Studio i platformy Vertex AI. Gdy model będzie gotowy do udostępnienia szerszemu gronu użytkowników, wprowadzona zostanie wersja 1.5 Pro z oknem kontekstowym o pojemności 128 tysięcy tokenów w standardzie. Planowane jest także ustalenie poziomów cenowych rozpoczynających się od wersji z oknem kontekstowym o pojemności właśnie 128 tysięcy tokenów oraz skalowanych do miliona tokenów w miarę ulepszania modelu.