Sztuczna inteligencjaRynek

Firma Aleph Alpha zaprezentowała innowacyjną architekturę LLM bez tokenizacji

Uczenie popularnych dużych modeli językowych (LLM) – m.in. nowych języków czy unikalnej wiedzy branżowej – przynosi niezadowalające rezultaty, a dostrajanie ich często okazuje się nieskuteczne. Kluczowym powodem jest to, że wzorce, których uczą się te LLM, opierają się na tokenizowanej wersji tekstu, na którym zostały wytrenowane. Jeśli nowy tekst znacznie różni się od oryginalnych danych treningowych, nie można go skutecznie tokenizować. W tym pomóc ma nowa architektura LLM od Aleph Alpha.

Nie wymaga ona tokenizera, rozszerzając możliwości LLM poza oryginalne dane treningowe. Takie podejście rozwiązuje kluczowy problem z obecnymi architekturami modeli językowych. Najczęściej mogą one bowiem być efektywnie trenowane tylko na danych wykorzystujących tokeny podobne do oryginalnych danych treningowych.

Technicznym terminem określającym nowy sposób pracy jest Hierarchical Autoregressive Transformers (HAT). Zamiast dzielić słowo, LLM są przetwarzane na poziomie całych słów lub pojedynczych bajtów – dokładne wyjaśnienie działania dostępne jest na stronie internetowej Aleph Alpha.

„W połączeniu z przełomową wydajnością najnowszej technologii AMD AI, oznacza to skok transformacyjny, odblokowując strategiczne możliwości, które wcześniej były poza zasięgiem” – zapewnia Jonas Andrulis, założyciel i dyrektor generalny Aleph Alpha.

Współpraca z AMD

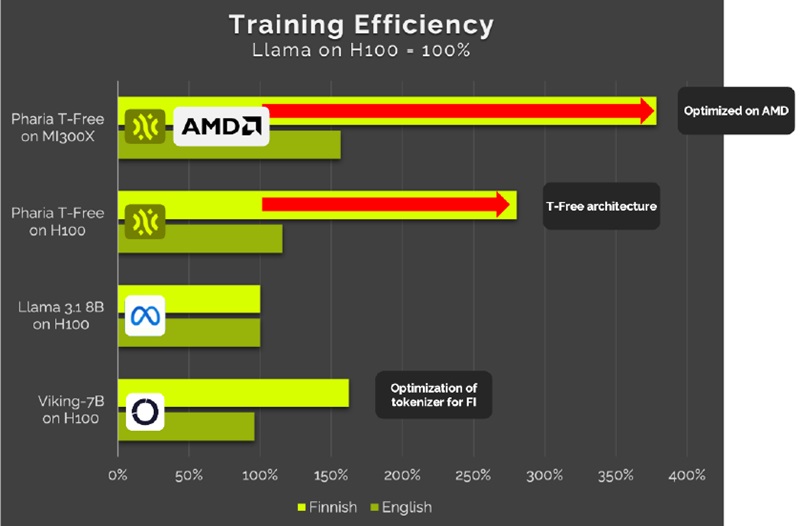

Technologia firmy Aleph Alpha, połączona z akceleratorami AMD Instinct MI300 oraz optymalizacją w otwartym środowisku programistycznym AMD ROCm, pozwala uzyskać znakomitą wydajność generatywnego AI. Duża pojemność pamięci akceleratorów AMD Instinct sprawia, że ta innowacja może działać szybko i efektywnie. Zwłaszcza w przypadku języków z małymi zasobami. Przykładowo, dla języka fińskiego (będącego szczególnie trudnym wyzwaniem) rozwiązanie to pozwala zaoszczędzić 70% TCO i o tyle samo zmniejszyć ślad węglowy w porównaniu z konkurencją.

Według przedstawicieli niemieckiego startupu specjalizującego się w GenAI, osiągnięcie to ma położyć podwaliny pod nową generację suwerennych rozwiązań AI. Umożliwi bowiem rządom i przedsiębiorstwom tworzenie własnych narzędzi w oparciu o ich języki ojczyste, specyfikacje kulturowe oraz specjalistyczną wiedzę i terminologię. W konsekwencji ma to zdemokratyzować dostęp do technologii i promować pluralizm gospodarczy oraz kulturowy.

„Ta współpraca wnosi coś więcej niż tylko samą sztuczną inteligencję – zapewnia odporność i innowacje dla

europejskiego ekosystemu AI” – podsumowuje Keith Strier, SVP, Global AI Markets w AMD.