BiznesAnalitykaCDOPolecane tematy

Reinforcement Learning, Generative Models i Deep Learning w analizie zachowań klientów

O analizie dużych zbiorów danych, wykorzystaniu ich do poznania preferencji konsumentów, sztucznej inteligencji, która ma powstać w ciągu najbliższych 20 lat, rozwiązaniach opartych o Reinforcement Learning, Generative Models i Deep Learning oraz idei tzw. Ambient Intelligence rozmawiamy z Jackiem Dąbrowskim, dyrektorem ds. technologii w niemieckiej firmie So1 GmbH.

Pierwszy algorytm jaki napisałeś?

To był Chat Bot, automat, który komunikował się z użytkownikami GaduGadu na bazie prostych reguł. Finałem takiej „rozmowy” było wysłanie linku do naszej strony. Projekt zrealizowałem jeszcze w czasach liceum. Po wielu innych, drobnych przedsięwzięciach, kolejny był system zarządzania ryzykiem dla X-Trade Brokers. Z kolei dla jednej z nowojorskich firm napisałem algorytm, który w ciągu 30 milisekund – na bazie dostępnych w Internecie informacji o użytkownikach – pozwalał podjąć decyzję, którą z 10 tys. reklam mu wyświetlić, aby zmaksymalizować ich efektywność. Najciekawsze rzeczy robię jednak teraz, pracując dla So1.

Czym zajmujesz się w So1?

Tworzymy algorytmy, które – w połączeniu z kartami lojalnościowymi i aplikacjami mobilnymi – pozwalają dużym, niemieckim sieciom handlowym tworzyć dla klientów dedykowane zestawy promocji. W tradycyjnych, papierowych ulotkach mamy kilkanaście, kilkadziesiąt stron z setkami różnych promocji. Dzięki naszym rozwiązaniom klient supermarketów otrzymuje kilka trafnie dobranych promocji, takich których prawdopodobieństwo skorzystania jest największe.

Przewidujemy m.in. czy dany produkt ktoś kupiłby bez promocji i jaki jest wpływ zniżek różnej wysokości. Dzięki temu budujemy tzw. nadwyżkę zakupową maksymalizując sprzedaż. Korzyść zyskują jednak nie tylko sieci handlowe. Dla klienta będzie to otrzymanie sprofilowanej pod niego promocji na produkty, które go najbardziej zainteresują z indywidualnymi atrakcyjnymi zniżkami. Dla supermarketów zwiększanie obrotu. Dodatkowo zaś zachęta do kupowania produktów, po które dany klient nigdy wcześniej nie sięgał. Dla marek będzie to zaś np. zachęcenie konsumenta do rezygnacji z produktów konkurenta. Supermarkety i marki rozliczają się z nami w ramach success fee.

W jaki sposób analizowane są dane kupujących?

Opracowany w So1 system jest w pełni anonimowy. Klient nie musi podawać żadnych informacji na swój temat. Nie musi się rejestrować. Nie wiemy kim jest z imienia i nazwiska. Wiemy jednak, co kupuje i prognozujemy co będzie kupował. Bazujemy na wszystkich, dokonywanych w danej sieci transakcjach – produktach, porach dnia, dniach tygodnia, lokalizacji sklepu i wydawanych kwotach. Choć tych parametrów jest znacznie więcej. Do indywidualnej analizy preferencji zakupowych wystarczą nam dane z 3 paragonów klienta. Już ta ich minimalna liczba pozwala nam dowiedzieć się prawie wszystkiego o danym konsumencie. Zysk dla algorytmów z kolejnych 5 koszyków zakupowych jest niewielki, choć pozwala poznać szczegółowe preferencje klienta dotyczące niszowych produktów.

Tworząc rozwiązania sztucznej inteligencji będziemy musieli wykorzystać Reinforcement Learning i Generative Models. Pierwsze z nich oparte jest na sposobie, w jaki się uczymy. Reinforcement Learning to w uproszczeniu systemy „rzucone” w nieznane środowisko i nie mające nauczyciela. Same muszą nauczyć się tak działać, aby jak najczęściej otrzymywać nagrodę. Z kolei Generative Models oparte są o modele probabilistyczne. Korzystając z nich otrzymujemy rozkład prawdopodobieństwa wszystkich możliwych zachowań czy obserwacji. Ten matematyczny model jest bliski temu, jak zachowuje się człowiek.

Celem stojącym za naszym działaniem jest jak najdokładniejsze modelowanie profili oraz uzyskanie jak najtrafniejszej informacji o tym, kiedy i gdzie dany konsument pójdzie do sklepu, a następnie co i w jakiej ilości kupi. Stosowane przez nas modele probabilistyczne (Generative Models – przyp. red.) generują scenariusze zachowania klienta w przyszłości o największym prawdopodobieństwie. Dzięki temu jesteśmy od 5 do 8 razy bardziej skuteczni niż losowo wysyłane promocje. Zerknięcie na przygotowany przez nas zestaw 8 promocji kończy się wykorzystaniem co najmniej jednej z nich aż w 60%, a obrót sklepów wzrasta o 3%.

Współpracujemy z firmami które prowadzą badania panelowe o konsumentach sieci handlowych. My zaś – na bazie paragonów – możemy z dużym prawdopodobieństwem odcyfrować dane socjodemograficzne takie jak płeć, stan cywilny, liczba osób w gospodarstwie domowym. Łącząc te informacje możemy targetować kampanie np. na rodziny z dwójką dzieci.

Z jakich jeszcze narzędzi – poza modelami probabilistycznymi – korzystacie?

Wykorzystujemy algorytmy Deep Learning. Każdy produkt, paragon i konsument jest reprezentowany wektorem. Po każdym, kolejnym zakupie dodawane są informacje, które aktualizują te wektory. Nasze algorytmy rozpoznają nawet nienazwane właściwości produktów. W uproszczeniu można dokonywane przez nie operacje, opisać takim równaniem:

(Banany bio) – banany + cebula = (cebula bio)

To bardzo prosty przykład właściwości, którą rozumiemy pod nazwą „eko produktu”. Analizujemy jednak dużo trudniejsze do „wyłapania” zależności. Wpływ na preferencje zakupowe może mieć np. ekskluzywne opakowanie produktu. To zaś można powiązać z tym, że dany produkt nie będzie zawierał produktów GMO, będzie dedykowany dla osób z nietolerancją laktozy itp. Informacji o estetyce, walorach smakowych czy modach i trendach nie znajdziemy na paragonie, w tabelach cech produktów ani na etykiecie. Dostarczają nam ich zachowania konsumentów. Opierając się na tych informacjach możemy proponować produkty podobne do lubianych przez klienta. Nasze algorytmy wykrywają i analizują ok. 800 cech. Kolejne 500 wymiarów opisuje konsumentów.

Wykorzystujemy algorytmy Deep Learning. Każdy produkt, paragon i konsument jest reprezentowany wektorem. Po każdym, kolejnym zakupie dodawane są informacje, które aktualizują te wektory. Nasze algorytmy rozpoznają nawet nienazwane właściwości produktów. Łącznie jest to ok. 800 cech. Informacji o estetyce, walorach smakowych czy modach i trendach nie znajdziemy na paragonie, w tabelach cech produktów ani na etykiecie. Dostarczają nam ich zachowania konsumentów.

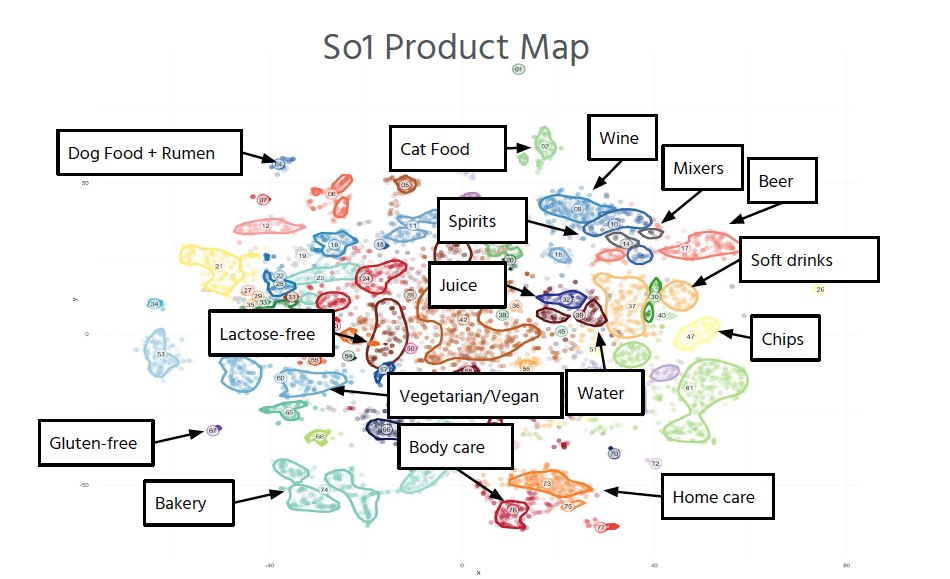

Co ciekawe, nasze algorytmy ignorują kategorie i podkategorie stosowane przez sieci handlowe. Tworzą własne, lepiej dopasowane do preferencji klientów hierarchie produktów wybieranych w pewnym kontekście, np. śniadaniowych. Inne rzeczy zaproponujemy więc w środę rano, a inne w piątek wieczorem. Rozkład tych 800 cech obrazuje wykorzystywana przez nas mapa wymiarów.

Obecnie większość działań koncentruje się na analizie dużych zbiorów danych o zachowaniach użytkowników…

Widzimy przyszłość w tym, że dane zbierane z wielu źródeł i w różnorodnym kontekście – nawet anonimowe – będą następnie w sposób algorytmiczny syntetyzowane. Będą poszerzać naszą perspektywę. Firmy telekomunikacyjne np. gromadzą dane o połączeniach, SMS-ach, naszej lokalizacji, zapytaniach do serwerów DNS itp. Być może przyszłością dla nich jest – przy spadających dochodach z połączeń i dostępu do internetu – przestawienie się na model wykorzystujący synergię tych danych.

Innym źródłem informacji są oczywiście pliki cookies i cała historia przeglądania przez nas stron internetowych. Dodatkowo od kilku lat każda ze stosowanych przez nas przeglądarek dysponuje własną sygnaturą tzw. fingerprint’em. Jej wersja, rozdzielczość, zainstalowane dodatki i wtyczki sprawiają, że nabiera ona unikalnych cech. Na tej podstawie strony internetowe są w stanie łatwo odróżnić nasze kliknięcia i dokładniej śledzić to, co robimy.

Na bazie danych operatora i informacji z sieci supermarketów jesteśmy w stanie zidentyfikować, że w obu przypadkach była to ta sama osoba. Dokonuje się tego na podstawie czasu transakcji i geolokalizacji. Już nawet 1% zidentyfikowanych osób pozwala na ekstrapolację danych na całą społeczność. Na tej podstawie otrzymujemy bardzo skuteczny model probabilistyczny. Do skutecznego targetowania w zupełności wystarczą anonimowe dane.

Połączenie tych wszystkich danych daje praktycznie kompletny obraz możliwych zachowań konsumentów. Przykładowo na bazie danych operatora i informacji z sieci supermarketów jesteśmy w stanie zidentyfikować, że w obu przypadkach była to ta sama osoba. Dokonuje się tego na podstawie czasu transakcji i geolokalizacji. Już nawet 1% zidentyfikowanych osób pozwala na ekstrapolację danych na całą społeczność. Na tej podstawie otrzymujemy bardzo skuteczny model probabilistyczny. Do skutecznego targetowania w zupełności wystarczą anonimowe dane. Nie ma bowiem znaczenia to, jak dana osoba się nazywa, lecz to, co robi, kiedy to robi, co lubi…

Czy to nie przerażające, że „maszyny” tak dużo o nas wiedzą?

Z jednej strony może wydawać się to przerażające, z drugiej jest nieuniknione. Koncepcja sklepów Amazon Go bazuje na tym, że są one najeżone kamerami i czujnikami analizującymi nasze zachowania. Docelowo tego typu rozwiązania znajdą się także w naszych domach. Nie ma odwrotu do czasów, gdy społeczeństwa funkcjonowały w oparciu o blokady informacyjne, gdzie tylko część osób miała pełny ogląd tego, co dzieje się na świecie.

Zmierzamy do społeczeństwa, w którym technologia będzie gromadziła ogromne ilości danych na nasz temat. Moim zdaniem nie będzie sensu panować na ich wyciekiem. Tym bardziej, że istnieje ryzyko, iż nierówny dostęp do informacji wszystkich podmiotów na rynku zostanie wykorzystany przeciwko nam. Musimy raczej dążyć do pełnej transparentności, aby wszyscy mieli do dostęp do zbieranych danych. Tym bardziej, że – jak wspomniałem wcześniej – dla przetwarzających je algorytmów nie ma znaczenia nasze imię i nazwisko.

Dziś działa wiele firm, które oferują bezpłatne usługi zarabiając na zbieranych na nasz temat informacjach. Godzimy się na to, a firmy oferujące nam usługi cyfrowe zarabiają na naszych anonimowy danych. Przykładowo roczne przychody Google na jednego, unikalnego użytkownika to ok. 277 USD, w przypadku Facebooka jest to 60 USD, LinkedIn 23 USD, a Twittera 15 USD.

Myślę, że opór przed udostępnianiem danych mają raczej starsze pokolenia. Kolejne coraz chętniej dzielą się „swoim życiem”. Mają coraz mniej sekretów i nie oczekują tak dużej prywatności. Starsze pokolenia są przerażone tym co się dzieje, ale zysk jaki rozwiązania Sztucznej Inteligencji i Machine Learning są w stanie – na bazie informacji na nasz temat – zaoferować jest niewyobrażalny.

Artykuł pochodzi z numeru ITwiz 2/2017