Tokeny Generative AI, czyli jak liczyć koszty zapytań do ChatGPT?

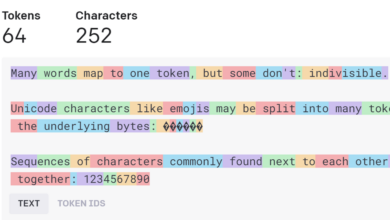

W dziedzinie sztucznej inteligencji termin tokenizacji odnosi się do procesu konwersji tekstu wejściowego na mniejsze jednostki lub „tokeny”, takie jak słowa lub podsłowa. Ma to fundamentalne znaczenie dla zadań przetwarzania…