Sztuczna inteligencjaRynek

Tokeny Generative AI, czyli jak liczyć koszty zapytań do ChatGPT?

W dziedzinie sztucznej inteligencji termin tokenizacji odnosi się do procesu konwersji tekstu wejściowego na mniejsze jednostki lub “tokeny”, takie jak słowa lub podsłowa. Ma to fundamentalne znaczenie dla zadań przetwarzania języka naturalnego (NLP), umożliwiając Generatywnej AI analizowanie i rozumienie ludzkiego języka. Tokeny odgrywają też bardzo ważną rolę w używaniu narzędzi AI jeszcze z innego powodu – koszt jaki ponosimy w trakcie ich stosowania, jest obliczany właśnie na ich podstawie. Jak zatem liczyć tokeny?

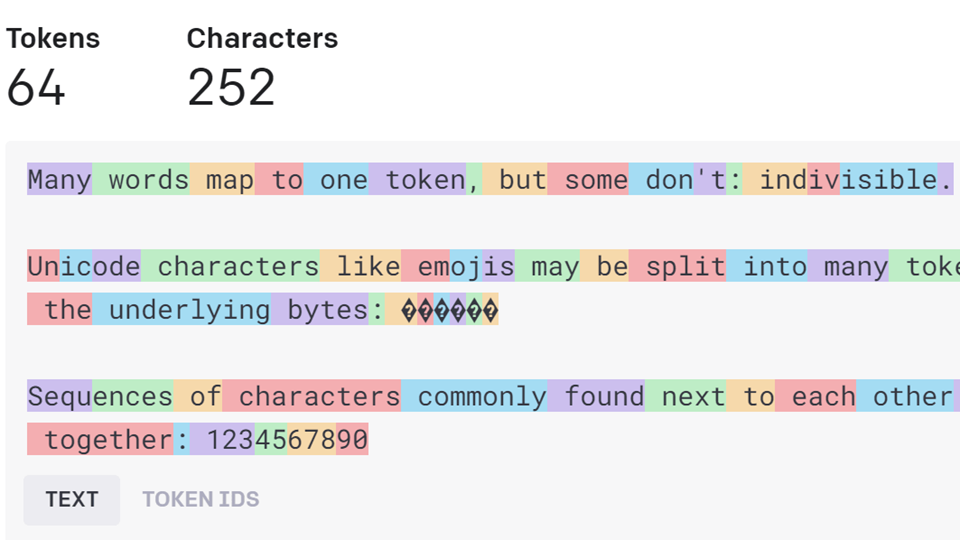

Tokeny można traktować jako fragmenty słów. Zanim API przetworzy żądanie, dane wejściowe są dzielone na tokeny. Nie są one jednak “cięte” dokładnie tam, gdzie zaczynają się lub kończą słowa. Tokeny mogą więc zawierać spacje końcowe, a nawet podsłowa.

Poniżej kilka pomocnych zasad dotyczących rozumienia tokenów pod względem długości:

1 token ~= 4 znaki w języku angielskim

1 token ~= ¾ słowa

100 tokenów ~= 75 słów

Lub

1-2 zdania ~= 30 tokenów

1 akapit ~= 100 tokenów

1500 słów ~= 2048 tokenów

Sposób dzielenia słów na tokeny jest oczywiście zależny również od języka. Przykładowo, zdanie “Jak napisać powieść?” w języku polskim ma 8 tokenów (20 znaków), podczas gdy w języku angielskim tylko 6 tokenów (21 znaków). Wyższy stosunek tokenów do znaków może sprawić, że implementacja API dla języków innych niż angielski będzie droższa.

Aby dokładniej zbadać tokenizację, można skorzystać z interaktywnego narzędzia firmy OpenAI, które pozwala obliczyć liczbę tokenów i zobaczyć, jak tekst jest na nie podzielony. Należy przy tym pamiętać, że dokładny proces tokenizacji różni się w zależności od modelu. Nowsze modele, takie jak GPT-3.5 i GPT-4, używają innego tokenizera niż poprzednie modele i będą generować różne tokeny dla tego samego tekstu wejściowego.

W zależności od używanego modelu, żądania mogą wykorzystywać do 128 000 tokenów współdzielonych między zapytaniem a zakończeniem. Niektóre modele, takie jak GPT-4 Turbo, mają różne limity tokenów wejściowych i wyjściowych. Istnieją również kreatywne sposoby rozwiązywania problemów w ramach limitu – np. skracanie podpowiedzi czy dzielenie tekstu na mniejsze części.

Co do konkretnych cen tokenów, to API oferuje wiele typów modeli w różnych punktach cenowych. Żądania do różnych modeli są różnie wyceniane. Szczegółowe informacje na temat cen tokenów można znaleźć tutaj.