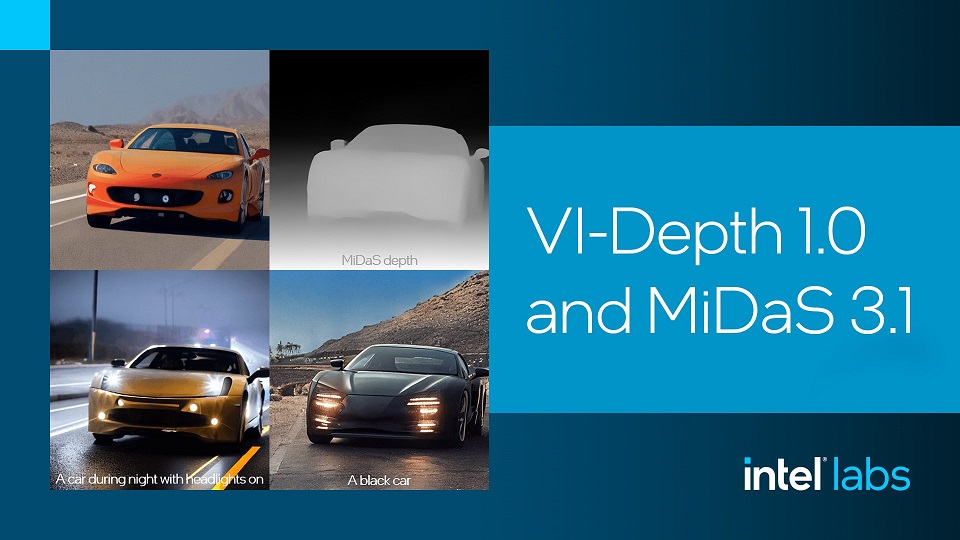

Mowa o VI-Depth 1.0 oraz MiDaS 3.1, które usprawniają proces szacowania głębi m.in. pod kątem zastosowania w aplikacjach wykorzystywanych w robotyce, rzeczywistości rozszerzonej (AR) oraz wirtualnej (VR). Co istotne, oba modele dystrybuowane są na licencji open source.

Najnowszy model do względnej estymacji głębi (RDE) – MiDaS w wersji 3.1 – jest w stanie funkcjonować używając tylko pojedynczego obrazu jako danych wejściowych. Dzięki wytrenowaniu na dużym i zróżnicowanym zbiorze danych, może on skutecznie działać w szerszym zakresie zadań oraz środowisk. Jednocześnie, najnowsza wersja modelu MiDaS poprawia dokładność estymacji głębi o około 30%.

Wedle zapowiedzi model ten został włączony do wielu projektów rozwojowych. Jednym z nich jest Stable Diffusion 2.0, gdzie umożliwia funkcję depth-to-image pozwalając na uzyskanie informacji o głębokości obrazu wejściowego, a następnie generując nowe obrazy z wykorzystaniem zarówno tekstu, jak i informacji o głębi.

Z kolei VI-Depth jest wizualno-inercyjnym potokiem szacowania głębi, odpowiadającym za integrację monokularnej estymacji głębi oraz wizualno-inercyjną odometrię (VIO), w celu wytworzenia gęstych estymacji głębi z metryczną skalą. Podejście to zapewnia dokładne szacowanie głębi, które może pomóc np. w rekonstrukcji scen, mapowaniu czy manipulacji obiektami.

Modele MiDaS 3.1 oraz VI-Depth 1.0 dostępne są na licencji open source MIT na GitHubie. Więcej na ich temat można przeczytać tu.