InfrastrukturaSztuczna inteligencjacentra danych / data centerCIORynekPolecane tematy

Szanse i wyzwania dla sztucznej inteligencji w centrum danych

W związkach AI z data center wszystko jest nowe. Nowe są szanse optymalizacji obsługi, nowe wyzwania dotyczące obciążeń i zużycia energii, nowe są wreszcie pomysły na samo data center obsługujące przetwarzanie AI.

Jakie implikacje niesie wzrost zapotrzebowania na wykorzystanie rozwiązań sztucznej inteligencji do poprawy efektywności centrów danych? Jak wpływa na rynek data center wzrost zapotrzebowania firm na przetwarzanie AI?

Inwestycje przy braku zaufania

Sztuczna inteligencja stwarza nowe szanse w zakresie optymalizacji zarządzania dostępną przestrzenią data center. Ale także bieżącej obsługi, zarządzania i optymalizacji całej infrastruktury centrów danych.

AI i ML zmieniają zarządzanie centrami danych poprzez automatyzację i optymalizację operacji. Dzięki predykcyjnej analityce, AI może przewidywać problemy, co pozwala na wdrażanie działań prewencyjnych. Dynamiczna alokacja zasobów w czasie rzeczywistym maksymalizuje wykorzystanie zasobów. AI przyczynia się do poprawy efektywności energetycznej, co jest kluczowe w kontekście zrównoważonego rozwoju.

A jednak, wśród zarządzających centrami danych zaufanie do podejmowania decyzji w oparciu o sztuczną inteligencję znacznie spadło w ciągu ostatnich trzech lat. W globalnym badaniu Uptime Institute przeprowadzonym w 2024 roku wśród menedżerów centrów danych, 42% operatorów stwierdziło, że nie zaufałoby nawet odpowiednio wyszkolonemu systemowi sztucznej inteligencji w podejmowaniu decyzji operacyjnych w data center. Deklarujących brak zaufania przybyło o 18 punktów procentowych od 2022 roku. Jeśli ten spadek zaufania utrzyma się, trudniej będzie wprowadzić narzędzia oparte na sztucznej inteligencji w sektorze centrów danych. Tymczasem, jeszcze 3 lata temu proporcje były odwrotne: trzy czwarte menedżerów deklarowało zaufanie do decyzji operacyjnych opartych na systemach AI.

W tym samym czasie, Uptime Institute donosi we wrześniowym raporcie „Artificial Intelligence and Software Survey”, że rośnie zastosowanie AI w centrach danych.

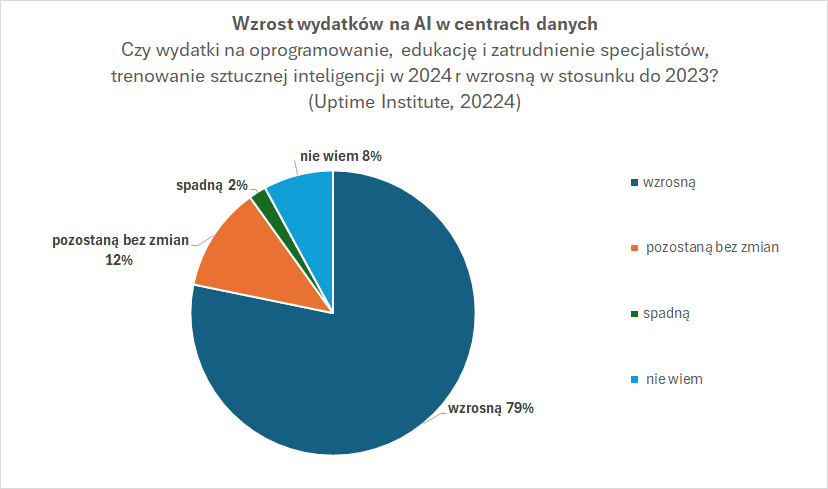

Przede wszystkim dlatego, że inwestycje się opłacają. 53% operatorów odnotowuje zwrot z inwestycji w AI (13% znaczący, 40% umiarkowany). Dlatego aż 79% planuje zwiększyć wydatki na AI w 2024 roku.

Większość ankietowanych (59%) twierdzi, że szkoli sztuczną inteligencję w swoich lokalnych centrach danych. Trenują AI także w innych lokalizacjach przetwarzania danych. Odpowiednio – w centrach kolokowanych (34%), w chmurach publicznych (31%) oraz na brzegu sieci (20%).

Największy wpływ na wybór przez organizację lokalizacji geograficznej dla przetwarzania obciążeń związanych z AI ma natomiast dostępność energii (42% odpowiedzi). Kolejne na liście czynniki to perspektywy dostępu do energii w przyszłości (37%), odnawialność infrastruktury (35%), bliskość klientów (34%), dostęp do jednostek przetwarzania GPU (35%) oraz konieczność likwidacji opóźnień w transmisji (26%).

Wykorzystanie sztucznej inteligencji zwiększa zapotrzebowanie organizacji na moc obliczeniową. Uważa tak aż 70% respondentów. Najwięcej, bo 37% tych menedżerów, wskazuje wzrost o 10-25%. Około jednej piątej prognozuje wzrost w przedziale 26-50% a 6% – wzrost o 100%. 16% ankietowanych nie zaobserwowało takiego wzrostu zapotrzebowania.

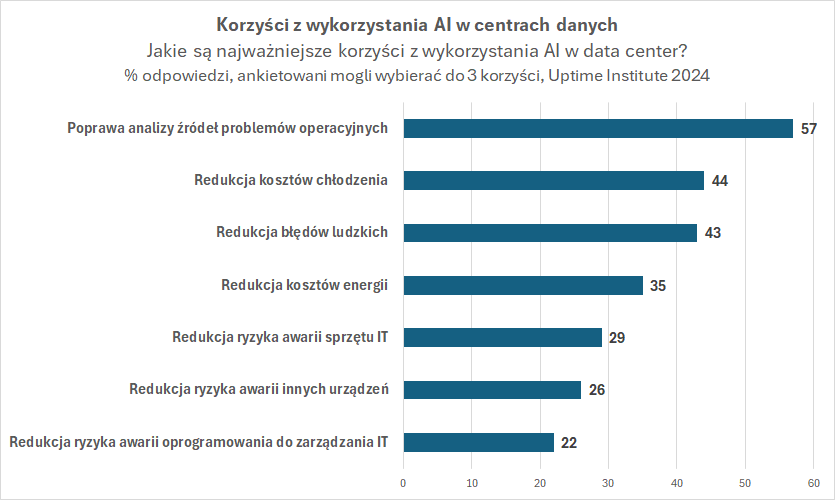

Jako główne korzyści z zastosowania AI, uczestnicy badania Uptime Institute wskazali poprawę analizy przyczyn problemów operacyjnych (57%), redukcję kosztów chłodzenia (44%) i zmniejszenie ryzyka błędów ludzkich (43%).

Zachłanna AI

AI to także zupełnie nowe wyzwania w zakresie użytkowania centrów danych. Inna jest skala obciążeń i gęstości mocy w przeliczeniu na jednostkę powierzchni centrum danych. O ile bowiem klasyczne serwery do działania potrzebują zwykle kilku-kilkunastu KW, to w przypadku systemów zoptymalizowanych do obsługi AI mówi się docelowo o kilkuset KW czy nawet wartości zbliżonych do MW na serwer. To z kolei oznacza nowe potrzeby związane z zasilaniem, ale też odprowadzaniem ciepła.

Z raportu CBRE “Global Data Center Trends 2024” opublikowanego w połowie roku wynika, że dla czołowych ośrodków przetwarzania danych na świecie priorytetem jest obecnie zapewnienie energii wobec rosnącego popytu na usługi. Popyt silnie obniża poziom wolnej przestrzeni w ofercie. Na przykład najbardziej deficytowy pod względem energii Singapur może zaoferować jedynie 7,2 MW dostępnej mocy przy poziomie wolnej przestrzeni na poziomie 1%. Deficyt mocy pompuje światowe ceny powierzchni w data center. W największych ośrodkach waha się on od 155 dolarów w Chicago do 480 dolarów w Singapurze za miesięczne zapotrzebowanie na poziomie za 250-500 kW.

Europejski rynek centrów danych wzrósł w I kwartale 2024 roku o prawie 20% licząc rok do roku. Znaczący wzrost odnotowały wszystkie cztery główne rynki (Frankfurt, Londyn, Amsterdam i Paryż – FLAP). Liderem był Paryż z ponad 40% wzrostem rok do roku. Niedobory podaży utrzymują się na całym kontynencie, zwłaszcza na głównych rynkach, takich jak Frankfurt. Przednajem nowych obiektów jest obecnie powszechny, co wskazuje na potrzebę ciągłych inwestycji w rozwój centrów danych. Kluczowym wyzwaniem jest pozyskiwanie energii.

Łączny wskaźnik pustostanów na rynkach FLAP spadł o 2 punkty procentowe rok do roku w pierwszym kwartale do 10,6%. Największy spadek odnotowano w Amsterdamie – o prawie 8 punktów procentowych do 11,5%. Pomimo spodziewanej nowej podaży, niski wskaźnik pustostanów powinien się utrzymać ze względu na silny popyt. Pomimo niekorzystnych czynników makroekonomicznych, popyt na centra danych w Europie pozostaje wysoki. Rynki FLAP odnotowały znaczny wzrost absorpcji netto, osiągając łącznie 487,6 MW od I kwartału 2023 r. do I kwartału 2024 r. To prawie dwukrotnie więcej niż w roku poprzednim.

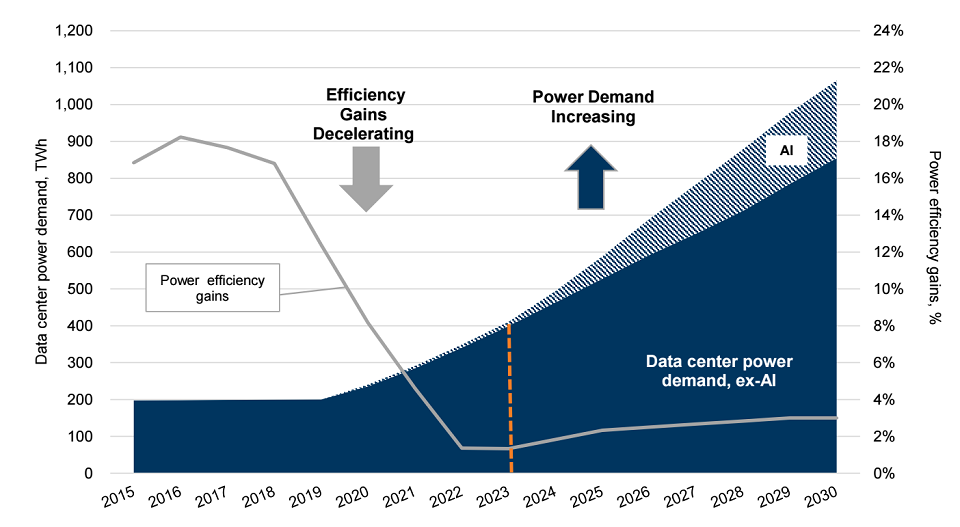

Prognoza Goldman Sachs opublikowana w raporcie z kwietnia br. zakłada również, że zapotrzebowanie na energię ze strony sztucznej inteligencji wzrośnie o około 200 TWh w latach 2024-30 (między 110-330 TWh). Sztuczna inteligencja będzie generować około 20% całkowitego zapotrzebowania na energię centrum danych.

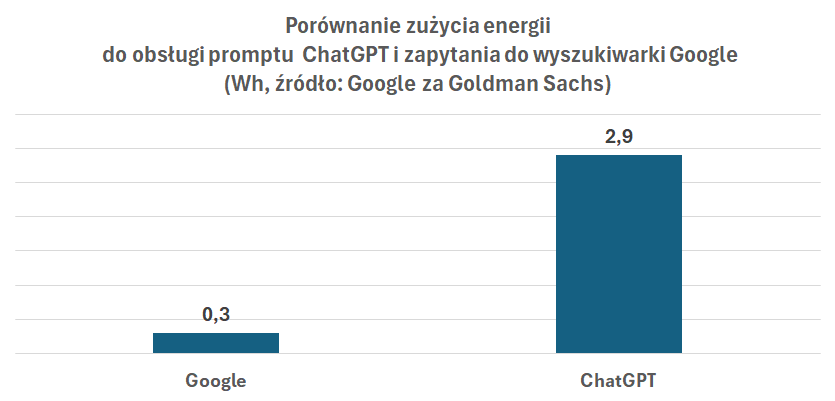

Ze względu na wzrost popytu na trenowanie modeli AI w horyzoncie średnioterminowym, analitycy Goldman Sachs przyjmują jednocześnie, że wzrost popytu na moce przewyższy poprawę wydajności (spadek energochłonności serwerów AI). Według klasycznego już oszacowania Google, wyszukiwanie przez ChatGPT pochłania średnio 6 do 10 razy więcej mocy niż tradycyjne zapytanie przez wyszukiwarkę internetową.

Średnia gęstość mocy w centrach danych wzrosła z 8 kW na racka do 17 kW w ciągu ostatnich dwóch lat. Przewiduje się, że do 2027 roku gęstość ta wzrośnie do 30 kW na jednostkę racka. Będzie to wynikiem rosnących wymagań związanych z obliczeniami AI.

Innowacje związane z zastosowaniem rozwiązań do obsługi AI ukierunkowane są na szybkość obliczeniową i maksymalne zużycie energii na serwer. Raport Goldman Sachs podaje, że o ile innowacje zmniejszyły energochłonność na serwer, to rzeczywiście zwiększyły ogólną moc na serwer. System NVIDIA DGX A100 ma osiągać 5 petaFLOPS i zużywać 6,5 kW mocy maksymalnej. To 1,30 kW na serwer lub 1,30 kW na pFLOPS. Nowszy system NVIDIA DGX H100 będzie realizować 32 petaFLOPS i zużywając maksymalnie 10,2 kW, czyli 0,32 kW na pFLOPS. System nowej generacji NVIDIA DGX B200 wykorzystujący nowe chipy Blackwell jest przewidziany do 72 petaFLOPS (trening) i zużycia 14,3 kW lub 0,20 kW na pFLOPS.

Oczywiście nie znaczy to, że takie maszyny od razu trafią do wszystkich centrów danych. Być może będą to zastosowania niszowe, jednak wymagające przemyślenia planów inwestycyjnych i modernizacyjnych w obszarze infrastruktury.