InfrastrukturaBiznes

HPE: Modernizacja IT w oparciu o dane od brzegu sieci, aż do chmury

Podczas niedawnej konferencji „Modernizacja IT zaczyna się od danych”, zorganizowanej przez HPE we współpracy z AMD, eksperci omawiali wyzwania i trendy występujące w branży. Była więc mowa m.in. o chmurze publicznej i prywatnej, brzegu sieci, „konsumpcji” i „grawitacji” danych, cyberbezpieczeństwie czy IT jako usłudze. Podczas wydarzenia zaprezentowano również najnowsze rozwiązania, umożliwiające skuteczną modernizację od brzegu sieci, poprzez data center, aż do chmury.

Jak zapewniali przedstawiciele HPE, dane to podstawowy i jeden z najważniejszych zasobów organizacji. To właśnie one, a nie technologia, napędzają model operacyjny przedsiębiorstwa. Strategia oparta na ich wykorzystaniu musi być wdrażana wraz z modernizacją technologii, zmianą procesów i praktyk. Polskie firmy mają duże możliwości rozwoju podejścia data-first, gdyż według wyliczeń McKinsey rodzima gospodarka cyfrowa jest największą w regionie Europie Środkowo-Wschodniej, a jej wartość osiągnęła 44 mld euro w 2021 roku. I choć głównym motorem wzrostu w ostatnich dwóch latach był e-commerce, na dalszy rozwój może wpłynąć szeroko pojęta technologia ICT, czyli wydatków organizacji na sprzęt, oprogramowanie, infrastrukturę i powiązane z nimi usługi. Według prognoz, sektor ten może przyczynić się do wzrostu na poziomie 76% do roku 2030.

„Transformacja cyfrowa rozprzestrzenia się na wszystkie branże. Nowe modele informatyczne ewoluują, aby wspierać coraz bardziej ulepszoną technologię w obszarach: edge computing, data, cloud i security. W HPE wychodzimy naprzeciw tym potrzebom. Poprzez innowacje w platformie HPE GreenLake pragniemy zapewnić organizacjom uelastycznienie środowisk IT pod kątem tych obszarów. Naszym celem jest zapewnienie aplikacjom i danym klientów elastyczności, dynamiki i cech zbliżonych do chmury publicznej, ale bez jej wad: a więc dodatkowych kosztów za transfer danych, nieprzewidywalności cenowej, ryzyk sygnalizowanych przez regulatorów czy wręcz niebezpieczeństwa utracenia dostępu do danych”– mówił podczas sesji plenarnej Krzysztof Kowalczyk, Sales Director, HPE Polska.

Wskazano również na bariery transformacji cyfrowej:

- przedsiębiorstwa potrzebują zwinności i skalowalności chmury, aby uzyskać przewagę nad konkurencją;

- potrzebują także przewidywalnych kosztów dostosowanych do możliwości biznesowych;

- dane biznesowe są uwięzione w silosach, w starych systemach, co utrudnia korzystanie z ich wartości;

- skomplikowanie systemów hybrydowych zwiększa koszty, ryzyka i spowalnia rentowność.

- Dane to podstawowy zasób, który należy kontrolować wszędzie tam gdzie się znajdują.

- Dane muszą być dostępne z prędkością ich rodzimej lokalizacji. Uwięzione dane są wadą, ich przepływ musi być bezproblemowy.

- Dane mają prawa i suwerenność. Muszą być zarządzane i chronione z pełną integralnością, aby były zgodne z przepisami.

- Wykorzystaj model cloud everywhere odpowiedni dla lokalizacji danych i obciążeń roboczych.

- Dane muszą zostać ujednolicone. Zastosowanie jednego zintegrowanego modelu zapewnia wgląd w dane, sprawność biznesową i wyniki.

Jak podkreślano, warto wziąć pod uwagę, że transformacja wiąże się z tzw. długiem technicznym, oddającym wartość całej pracy technologicznej, którą firma musi wykonać, aby rozwiązać komplikacje spowodowane przez stare systemy. Specjaliści IT mierzą go w odniesieniu do wartości całego majątku technologicznego, co może przełożyć się na setki milionów „niespłaconego” długu w przypadku dużych organizacji. Stąd, według ekspertów, migracja do chmury wydaje się jednym z najskuteczniejszych sposobów na szybką spłatę tego długu, choć takie migracje nie są same w sobie idealnym rozwiązaniem. Wiele organizacji przeniosło się do chmury tylko po to, by odkryć, że wielopokoleniowe silosy IT nadal istnieją jako część architektury wielochmurowej. Dlatego transformacja zorientowana na dane wymaga dogłębnego przeanalizowania potrzeb architektonicznych, a nie przenoszenia obciążenia z maszyn lokalnych na chmurowe, gdyż wciąż ponad 70% aplikacji i danych znajduje się poza chmurą publiczną – wskazywali specjaliści HPE.

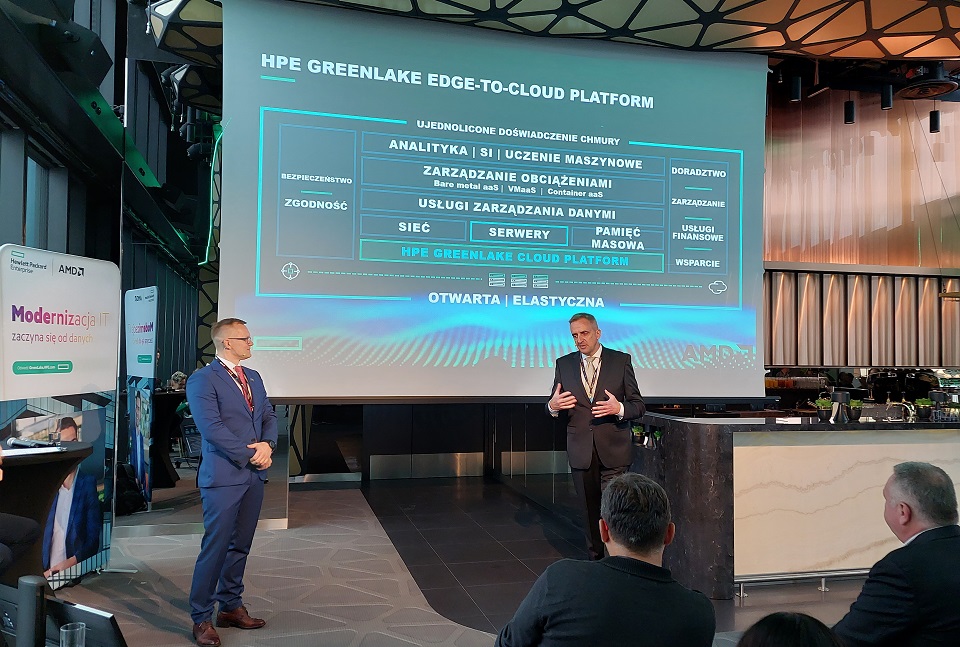

Jednocześnie zapewniali, że dostrzegając to wyzwanie, cały czas udoskonalają swoje rozwiązania, aby mogły one w pełni skorzystać z możliwości, które daje swoboda działania od brzegu sieci do chmury. Takim rozwiązaniem jest ich zdaniem platforma HPE GreenLake, umożliwiająca udostępnianie zasobów i danych w centrum danych, na brzegu sieci czy w chmurze publicznej, z poziomu jednego portalu, a wszystko dostarczane jest w modelu usługowym. Dzięki takiemu podejściu firmy mogą budować modele biznesowe optymalnie dopasowane do potrzeb ich klientów i efektywnie konkurować na rynku, uważają przedstawiciele HPE.

Rozwiązania wspierające wdrożenie podejścia data-first

Jednym z wątków poruszanych podczas konferencji był ten dotyczący strategii data-first, która opiera się na ukierunkowaniu każdego aspektu organizacji na efektywne wykorzystanie danych, mieszczących się często w tradycyjnych czy nieelastycznych architekturach. Dlatego właśnie organizacje, aby odnieść sukces, potrzebują niezawodnych rozwiązań pomagających w zbieraniu danych, ich przechowywaniu, zarządzaniu oraz analizowaniu. Jak zapewniali prelegenci, efektywnie, a jednocześnie bezpiecznie, wykorzystać wartość płynącą z danych można nie tylko dzięki elastycznym platformom software, ale również dostosowanym do coraz bardziej szczegółowych potrzeb urządzeniom oraz pamięciom masowym.

W związku z tym, że organizacje wykonują coraz bardziej wymagające zadania do przetwarzania danych obejmujące sztuczną inteligencję, uczenie maszynowe czy renderowanie, niezbędna jest więc optymalizacja wykorzystania mocy obliczeniowej i sprawne obliczenia. Stąd rośnie potrzeba inwestowania w serwery, które zapewnią niezbędną wydajność przy obciążeniach wykorzystujących duże ilości danych i mogą być zastosowane do różnych zestawów architektur, a jednocześnie są łatwe w zarządzaniu i elastyczne.

Żeby nie być gołosłownym, przedstawiciele HPE i AMD zaprezentowali wspólnie nowe serwery HPE ProLiant Gen11, wyposażone w nowoczesny procesor AMD EPYC 4. generacji. Jak zapewniali, rozwiązania te osiągają rekordowe wyniki w testach porównawczych – oferują one wzrost wydajności nawet o ponad 90% w porównaniu do poprzedniej generacji, przy większej efektywności energetycznej.

“Nie ma takich obciążeń, którym nie byłyby one w stanie sprostać. Serwery HPE ProLiant nowej generacji mogą posłużyć jako wzorcowa technologia serwerowa znacznie ułatwiająca i przyspieszająca modernizację IT, co ma kluczowe znaczenie dla potrzeb organizacji, które chcą zyskać przewagę konkurencyjną oraz wdrożyć podejście data-first” – stwierdził Paweł Wójcik, HV and Compute & Data Services Lead w HPE Polska.

Innym rozwiązaniem, które również zaprezentowano podczas wydarzenia, była pamięć masowa HPE GreenLake for Block Storage, będąca – jak zapewniali przedstawiciele producenta – jedynym na rynku rozwiązaniem zapewniającym samoobsługę i dającym 100% gwarancję dostępności dla środowisk o znaczeniu krytycznym. Jest to usługa pozwalająca na obsługę danych w chmurze – oferowana w ramach platformy HPE GreenLake – która upraszcza zarządzanie lokalną pamięcią masową, dzięki szybkości i sprawności chmury.

Wspominano również o innowacyjnej usłudze HPE GreenLake for DataFabric, która w jednym miejscu łączy dane, aplikacje oraz konta użytkowników niezależnie od ich fizycznej lokalizacji – na krawędzi sieci, centrum danych czy chmury publicznej. Poprzez ujednolicone zarządzanie danymi, obsługę danych multimodalnych, zoptymalizowaną wydajność oraz wbudowany ekosystem aplikacji do przetwarzania – platforma ta w bezpieczny sposób przyspiesza pełne wykorzystanie danych zgromadzonych w przedsiębiorstwie, zapewniano uczestników konferencji.

Podczas wydarzenia eksperci konsekwentnie podkreślali, że przetwarzanie i operacje na danych w miejscu ich tworzenia, głównie na brzegu sieci, doprowadzi do szybszych i bardziej wymiernych wyników biznesowych. Dzisiaj organizacje wciąż próbują przechowywać i przetwarzać dane w miejscu, w którym można je w pełni kontrolować. Ten paradygmat musi ulec zmianie, aby firmy w pełni uwolniły wartość gromadzonych i przechowywanych w wielu miejscach danych, podsumowali specjaliści.