CIOPolecane tematy

Wszystko musi być dziś kompatybilne z architekturą x86

Z Pawłem Gepnerem, HPC Platform Architect z EMEA Technical Group w Intel Corporation, rozmawiamy o High Performance Computing; wspierających je technologiach; nowych, dedykowanych rozwiązaniach, procesorach i rozwoju technologii dla data center.

Za każdym razem, gdy uczestniczę w konferencji dużego producenta sprzętu, pojawia się logo Intela, zwłaszcza w kontekście rozwiązań dla centrów danych. Jaka jest wizja Intela, jeśli chodzi o rozwój data center? Nad jakimi technologiami dziś Państwo pracujecie?

Dział Data Center Group być może nie jest najbardziej widoczny, ale wkrótce ma szansę stać się jednym z najbardziej dynamicznie rozwijających się i zyskownych w całym Intelu. Coraz więcej urządzeń – a wkrótce i przedmiotów – podłączanych jest do sieci. Tymczasem na każde 10 urządzeń końcowych podłączonych do internetu potrzebny jest jeden serwer w centrum danych, aby nimi zarządzać, obsługiwać je, udostępniać im usługi w chmurze.

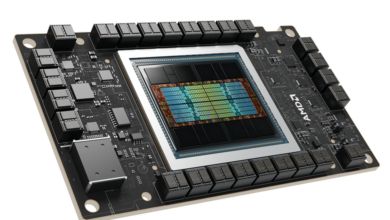

Na potrzeby serwerów w data center – a w szczególności tych stosowanych do High Performance Computing – tworzymy dedykowane rozwiązania, w tym i procesory. Najbardziej oczekiwanym z nich jest Intel Xeon Phi, który pojawi się na rynku w 2016 r. Obecnie mamy dwa standardy rozwiązań stosowane w systemach HPC: procesory Intel Xeon i koprocesory Intel Xeon Phi. Intel Xeon ma stosunkowo małą ilość bardzo wydajnych rdzeni – maksymalnie 18. Natomiast Intel Xeon Phi przeznaczony jest do rozwiązań masywnie równoległych, z duża ilością rdzeni, chociaż mniej wydajnych.

Trudno wyobrazić sobie skutecznie i bezpiecznie działający mechanizm maszyn wirtualnych bez wsparcia technologii Intel VT-x zaimplementowanej po raz pierwszy w naszych procesorach już w roku 2005. Niewiele osób zdaje sobie z tego sprawę, ale to m.in. nasze narzędzia pozwalają na to, aby rozwiązania do wirtualizacji zadziałały tak efektywnie i przede wszystkim bezpiecznie. Robiąc coś w oprogramowaniu, trzeba mieć bowiem wsparcie w sprzęcie. Chyba nie będzie przesadą stwierdzenie, że wszystko musi być dziś kompatybilne z architekturą x86.

Nowy już procesor – a nie koprocesor – z rodziny Intel Xeon Phi będzie wyposażony w bardzo efektywną jednostkę zmiennoprzecinkową. Warto też dodać, że powstaje on w technologii 14 nm i będzie dysponował ponad 60 rdzeniami. Intel Xeon Phi będzie też zawierał rozszerzenie listy instrukcji dedykowanych do obliczeń inżynierskich i High Performance Computing – Intel AVX-512.

Procesor Intel Xeon Phi wprowadza również nową jakość do rozwiązań HPC. W obrębie 1 procesora i 60 rdzeni układ ten oferuje gigantyczny wzrost wydajności, do 3 TFLOPS (double precision) per socket. Aby osiągnąć wydajność 1 PFLOPS, potrzeba będzie zaledwie ok. 350 „klocków”, a każdy z nich będzie miał o 25% większą energooszczędność niż obecne procesory.

Najszybszy dziś superkomputer na liście TOP 500, chiński Tianhe-2, zużywa 17,8 MW – czyli tyle, co małe miasteczko – a jego wydajność to ok. 34 PFLOPS. Wykorzystuje ponad 3 mln procesorów. Tymczasem we Francji pracujemy nad projektem superkomputera o podobnej mocy obliczeniowej, który będzie wykorzystywał zaledwie 10 tys. procesorów! Łącznie będzie to już jednak ponad 600 tys. rdzeni. Oczywiście, większość technologii do jego stworzenia jeszcze nie istnieje.

Na czym polega projektowanie takiego superkomputera?

Kiedy zaczyna się projekt, porównujemy oczekiwania zamawiającego z tym, co mamy do zaoferowania i co będziemy mieli w określonym horyzoncie czasowym. Projektowanie obejmuje m.in. procesor, infrastrukturę sieciową i system operacyjny. Dopiero teraz pracujemy np. nad pewnymi elementami do kernela Linuksa, który będzie wykorzystywany jako system operacyjny dla superkomputera powstającego we Francji, o którym mówiłem. Nie wiadomo także z jakiego standardu pamięci będziemy korzystać. Podobnie gdy dwa lata temu planowaliśmy zastosowanie w rozwiązaniach HPC pamięci DDR4, ich standardu wówczas nawet nie było. Choć dostępne było już bardzo dużo gotowej dokumentacji, to oficjalna specyfikacja nie była zatwierdzona.

Jeśli ktoś z czytelników chciałby zrobić zawrotną karierę w Intelu, powinien być lub zostać specjalistą w dziedzinie inżynierii materiałowej czy procesowej. Zaprojektowanie najszybszego procesora to wielkie wyzwanie, ale dużo trudniejsze jest jego wyprodukowanie, i to na masową skalę. Do tego potrzebne są właśnie nowe materiały, nowoczesne technologie i zaawansowane procesy produkcyjne.

Oczywiście najwcześniejszy jest proces projektowy procesora. Planując nowe produkty, myśli się o przyszłych wymaganiach, obciążeniach, jak również o tym, jak będzie wyglądać centrum danych przyszłości. Przykładowo, Intel Xeon Phi projektowany był początkowo jako koprocesor, wykorzystujący do komunikacji złącze PCIe. Został on opracowany jako wsparcie tradycyjnego CPU w zakresie wieloziarnistych zadań – Highly Parallel Workload. Uznaliśmy jednak, że system, który ma dwie instancje pamięci, jest mało efektywny. Wówczas pojawił się pomysł stworzenia procesora przeznaczonego do przetwarzania zadań HPC, i to tylko tych o wielkim stopniu ziarnistości, rzędu milionów wątków. Zastosowaniem dla tego typu procesorów jest np. metoda Monte Carlo. Typowym przykładem jej wykorzystania może być modelowanie wyniku zderzenia cząstki o wysokiej energii z jądrem złożonym, gdzie każdy akt zderzenia elementarnego – z pojedynczym nukleonem jądra – modelowany jest oddzielnie poprzez losowanie liczby, rodzaju, kąta emisji, energii itp. cząstek wtórnych emitowanych w wyniku takiego zderzenia.

Intel to już jednak nie tylko procesory w serwerach stosowanych w centrach danych…

Oczywiście, że nie. Są to także chipsety, dyski SSD i inne komponenty, w tym również nasze oprogramowanie do zarządzania Intel Datacenter Manager oferowane w ramach umów OEM dostawcom gotowych rozwiązań. Mamy też nową inicjatywę Intel Rack Scale Architecture. To idea bardzo podobna do inicjatywy Network Oriented Infrastructure. Wokół Intel Rack Scale Architecture toczy się wiele projektów, ponieważ musimy stworzyć mechanizmy zapewniające wsparcie powstających technologii już na poziomie procesora. Podobnie było ze wsparciem wirtualizacji.

Najszybszy dziś superkomputer na liście TOP 500, chiński Tianhe-2, zużywa 17,8 MW – czyli tyle, co małe miasteczko – a jego wydajność to ok. 34 PFLOPS. Wykorzystuje ponad 3 mln procesorów. Tymczasem we Francji pracujemy nad projektem superkomputera o podobnej mocy, który będzie wykorzystywał zaledwie 10 tys. procesorów!

Trudno wyobrazić sobie skutecznie i bezpiecznie działający mechanizm maszyn wirtualnych bez wsparcia technologii Intel VT-x zaimplementowanej po raz pierwszy w naszych procesorach już w roku 2005. Niewiele osób zdaje sobie z tego sprawę, ale to m.in. nasze narzędzia pozwalają na to, aby rozwiązania do wirtualizacji zadziałały tak efektywnie i przede wszystkim bezpiecznie. Robiąc coś w oprogramowaniu, trzeba mieć bowiem wsparcie w sprzęcie. Chyba nie będzie przesadą stwierdzenie, że wszystko musi być dziś kompatybilne z architekturą x86.

W pracach projektowych staramy się podejść w sposób holistyczny do tematu nowoczesnych centrów danych, a więc od ogółu do szczegółu. Dlatego w naszym dziale Data Center Group powstają takie rozwiązania, jak następca InfiniBand czy sukcesor Intel QuickPath Interconnect. Pracujemy także nad zarządzaniem ciepłem w ramach centrum danych. Podstawą w tym kontekście są nadal coraz bardziej wydajne półprzewodniki, które stanowią fundament i kwintesencję działalności Intela. Oczywiście wszędzie mówi się też o grafenie czy nanorurkach, ale od fazy eksperymentów, w której obecnie jesteśmy, do stabilnej technologii jest jeszcze bardzo długa droga. Intel też prowadzi badania nad takimi, alternatywnymi technologiami.

Pracujemy również nad technologiami przyszłości, z których korzystać będą nasze procesory. Obecnie powstają one w 14 nm procesie technologicznym, ale kolejne generacje są planowane zgodnie z naszym cyklem Tick-Tock. Każdy nowy proces technologiczny to szybsze i bardziej energooszczędne procesory, a także większa liczba tranzystorów na jednym kawałku krzemu. Jeśli ktoś z czytelników chciałby zrobić zawrotną karierę w Intelu, powinien być lub zostać specjalistą w dziedzinie inżynierii materiałowej czy procesowej. Zaprojektowanie najszybszego procesora to wielkie wyzwanie, ale dużo trudniejsze jest jego wyprodukowanie, i to na masową skalę . Do tego potrzebne są właśnie nowe materiały, nowoczesne technologie i zaawansowane procesy produkcyjne.

Intel Xeon Phi projektowany był początkowo jako koprocesor, wykorzystujący do komunikacji złącze PCIe. Został opracowany jako wsparcie tradycyjnego CPU w zakresie wieloziarnistych zadań – Highly Parallel Workload. Uznaliśmy jednak, że system, który ma dwie instancje pamięci, jest mało efektywny. Wówczas pojawił się pomysł stworzenia dedykowanego procesora.

Wspiera Pan klientów Intela przy projektach typu HPC. Jaki był największy superkomputer, przy którym Pan pracował?

Był to francuski superkomputer Curie o wydajności 1,4 PFLOPS, który znajduje się w Centrum Badań Nuklearnych CEA. Kiedyś był największym w Europie i jednym z pięciu największych na świecie. Oparty został na naszych procesorach z rodziny Intel Xeon i serwerach firmy Bull. Superkomputer ten służy do badań nad fizyką wysokich energii. Teraz – jak już wspomniałem – pracuję nad czymś jeszcze większym, i to także będzie projekt europejski.