RynekPolecane tematy

Memrystory i fotonika nadzieją na energoszczędne centra danych według HP

Według szacunków HP Przy obecnym tempie rozwoju światowych centrów danych tylko w ciągu trzech najbliższych lat najwięksi dostawcy usług internetowych i chmurowych potrzebować będą dodatkowych 10 mln serwerów. Ostrożne szacunki kosztów zakupu takiej ilości sprzętu mogą sięgnąć 20 mld USD. A co z zapotrzebowaniem na prąd oraz efektywnością energetyczną?

“Gdyby wszystkie działające na świecie środowiska cloud computing połączyć w jedną chmurę obliczeniową, to rocznie zużywałaby ona pięciokrotnie więcej energii niż kraj wielkości Hiszpanii” – twierdzi Meg Whitman, dyrektor generalna koncernu HP. Odniesienie do największego państwa Półwyspu Iberyjskiego jest nieprzypadkowe – takie stwierdzenie padło podczas odbywającej się w Barcelonie, europejskiej edycji konferencji HP Discover 2013.

Odpowiedzią HP ma być zapowiedź wprowadzenia do powszechnego użycia memrystorów oraz optycznych układów transamisji danych.

Według niej dzisiejsze centra danych odpowiadają za zużycie ok. 2% światowego zużycia energii elektrycznej. “Jeśli obecne trendy nie ulegną zmianie, to do końca tej dekady udział ten przekroczy 3%” – dodaje dyrektor generalna koncernu HP. Jej zdaniem o ile oczekiwania w zakresie mocy obliczeniowej dynamicznie rosną, tak architektura sprzętu serwerowego na przestrzeni kilku ostatnich dziesięcioleci zmieniła się tylko nieznacznie. Według przedstawicieli HP obecnie ok. 90% energii wykorzystywanej przez sprzęt serwerowy jest wydatkowane na przemieszczanie danych między różnymi komponentami typowych serwerów – od pamięci masowych, przez pamięć operacyjną, po procesor. “Potrzebna jest architektura pozwalająca łatwiej gromadzić większe ilości danych, szybciej je przemieszczać i przetwarzać w sposób bardziej efektywny” – dodaje Meg Whitman.

Odpowiedzią HP na tego typu potrzeby ma być zapowiedź wprowadzenia do powszechnego użycia memrystorów – biernych elementów elektronicznych, których wykorzystanie w kontekście pamięci masowych ma pozwalać na tworzenie nieulotnych pamięci charakteryzujących się ogromną gęstością zapisu przy jednoczesnym zapewnieniu dużej szybkości dostępu do danych. Prace nad rozwojem memrystorów są prowadzone w kilku ośrodkach rozwojowych na świecie. Należą do nich również laboratoria HP, gdzie wyprodukowano pierwsze tego typu, wydajne układy. Chociaż idea takich układów została opracowana ponad 40 lat temu, to pierwsze memrystory zostały wyprodukowane dopiero w 2008 roku – w ośrodku HP Labs.

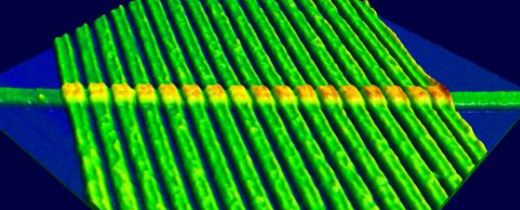

Inną technologią, która zdaniem przedstawicieli HP odegra kluczową rolę w rozwoju architektury serwerowej pozwalającej sprostać wyzwaniom związanych z potrzebą gromadzenia i przetwarzania coraz większych ilości informacji jest fotonika. Wykorzystanie miniaturowych układów optycznych pozwalających efektywnie przetwarzać impulsy elektryczne na przesyłane dedykowanymi kanałami światłowodowymi sygnały świetlne, a tym samym zastąpienie elektronów fotonami w kontekście transmisji danych, ma pozwalać na tworzenie interfejsów zdolnych do przesyłania nawet 6TB danych na sekundę. Wedle zapowiedzi prace nad tego typu układami optycznymi są już realizowane.

Dodatkowe korzyści mają wynikać z wykorzystania nowych – w przypadku HP opartych na platformie HAVEn – rozwiązań aplikacyjnych, pozwalających w sposób bardziej efektywny przetwarzać dane. Rozwijana przez HP platforma HAVEn ma wspierać procesy przechwytywania, gromadzenia i analizowania danych oraz ich dystrybucji w odpowiednio sprofilowanej postaci. Oparte na własnych technologiach HP oraz platformie Hadoop środowisko ma w efektywny sposób obsługiwać wszelkie rodzaje informacji – dane ustrukturyzowane, nieuporządkowane oraz wszelkie formy pośrednie. Cechą charakterystyczną środowiska HAVEn mają być m.in wbudowane narzędzia ułatwiające zarządzanie mechanizmami przetwarzania Big Data oraz dedykowane – rozwijane m.in. przez partnerów HP – aplikacje wspierające analizę danych w konktretnych zastosowaniach wertykalnych.